la autopercepción del participante de una formación es indicativa de la obtención de sus objetivos, pero la funcionalidad y la aplicabilidad del instrumento utilizado para evaluarla deben ser sometidas a un proceso de análisis cualitativo y cuantitativo. La simulación es una metodología formativa experiencial y colaborativa, generalmente multidimensional y costosa, que precisa instrumentos fiables para valorar su eficacia. Este estudio describe el proceso de creación y validación de una encuesta para evaluar la opinión de las personas que participan en formaciones impartidas con metodología de simulación.

Métodoel proceso tuvo una fase cualitativa, con 2 etapas para la obtención de evidencias en el contenido, de respuestas a través de un comité de expertos interno (n = 6) y otro externo (n = 15), y de aplicación del instrumento a los participantes en 3 ocasiones (n = 10; n = 104; n = 446), así como del análisis en un focus group de participantes (n = 35) respecto a la estructura, comprensión y contenido. Además, una fase cuantitativa, con análisis psicométricos para el reajuste y medición del instrumento.

Resultadostras el proceso, se obtuvo una encuesta final con 24 preguntas con respuestas de 4 categorías categóricas ordinales, la cual muestra una estructura interna unidimensional del 71,1% de la variancia total. Los índices de ajuste modelo fueron χ2 = 123,936 (p < 0,001), d.f. = 48,67; RMSEA = 0,00; CFI = 1,00; TLI =1,00. Mostró correlación con otras variables (r = 0,7) y fiabilidad de α= 0,963 (0,957-0,967); ω = 0,963 (0,955-0,970).

Conclusiónla combinación de métodos cualitativos con cuantitativos ha permitido depurar el instrumento y detectar errores de método para reajustar el instrumento sin que afectara a su representatividad. La encuesta es válida para valorar, por estudiantes y profesionales, la eficacia de sesiones de simulación formativa y poder detectar oportunidades de mejora.

The participant's self-perception of a training is indicative of the achievement of its objectives, but the functionality and applicability of the instrument used to evaluate it must be submitted to a process of qualitative and quantitative analysis. Simulation is an experiential and collaborative training methodology, generally multidimensional and costly, which requires reliable instruments to assess its effectiveness. This study describes the process to create and validate a survey to assess the opinion of participants in a learning activity with simulation methodology.

MethodThe process included a qualitative phase with two stages for obtaining content evidence, responses from an internal (n = 6) and external (n = 15) expert committee, and administration of the instrument to participants on three occasions (n = 10; n = 104; n = 446), as well as analysis in a focus group of participants (n = 35) regarding the structure, comprehension, and content. This phase also included a quantitative phase with psychometric analysis for the adjustment and measurement of the instrument.

ResultsAfter the process, a final survey was obtained with 24 questions with answers from 4 ordinal categorical categories, which shows a unidimensional internal structure of 71.1% of the total variance. The model fit indices were χ2 = 123.936 (p < 0.001), d.f. = 48.67; RMSEA = 0.00; CFI = 1.00; TLI =1.00. It showed correlation with other variables (r = 0.7) and reliability of α= 0,963 (0.957–0.967); ω = 0.963 (0.955–0.970).

ConclusionThe combination of qualitative and quantitative methods made it possible to refine the instrument and detect method errors to readjust the instrument without affecting its representativeness. The survey is valid for students and professionals to assess the effectiveness of training simulation sessions, and to detect opportunities for improve them.

Dentro del ámbito académico, los criterios de calidad deben evidenciarse desde la opinión de las personas que reciben el impacto directo de una formación1. La simulación es una metodología educativa experiencial muy utilizada en ciencias de la salud, que entrena al participante a actuar en una situación lo más fiel posible a la realidad que deberá afrontar. La simulación se centra en las necesidades variables de aprendizaje que tienen los participantes, desde estudiantes de diferentes grados hasta la formación continua de los profesionales activos. Para que la simulación sea eficaz, se precisan de las aportaciones de expertos temáticos y metodológicos para el diseño de una formación, así como la valoración de las personas participantes en ella2. La simulación es costosa en términos de tiempo y recursos, y es necesario valorar su eficacia y eficiencia con instrumentos que deben ser válidos, confiables y alineados con los objetivos de la enseñanza. Existen instrumentos validados para algunas de las competencias que se enseñan en simulación, como es la comunicación3,4, pero no se dispone de ninguno que aborde la opinión sobre el aprendizaje obtenido con los diferentes componentes de la simulación y que sea aplicable a participantes de distintos ámbitos de las ciencias de la salud. Es necesario establecer mecanismos fiables que permitan obtener dicha opinión respecto a la preparación, ejecución y beneficios obtenidos con la metodología docente que se aplica5.

Herramientas como las encuestas permiten mejorar el producto docente6, y dan al participante la opción de opinar respecto a la autopercepción del aprendizaje, la transferencia u organización, entre otros. Todos los enfoques son claves para obtener una valoración holística de la actividad7,8.

Una encuesta debe crearse con base en un objetivo bien definido y demostrar que posee un constructo sólido que permite obtener resultados fiables9. Debe tener propiedades que permitan la validación de otros instrumentos4. La literatura actual aporta elementos conceptuales que van más allá del conocido método Delphi10 y describen el proceso de validación11. Un compendio de evidencias cualitativas y cuantitativas forma parte de un proceso que, no por ser riguroso, es definitivo12,13, y cuantas más evidencias puedan fortalecer este proceso, más fiabilidad obtendrá a su favor14. El proceso de validez de una encuesta permite analizar el objetivo en el que se enmarcan las preguntas creadas. A esto debe sumarse el proceso de respuesta, que analiza la comprensión de las preguntas y el tiempo requerido de respuesta. La psicometría informa respecto a la correlación de las preguntas que configuran la estructura interna. Cualquier encuesta debe contar con expertos en el campo y en psicometría, y ser probada con los sujetos a quienes irá dirigido el instrumento, tantas veces como sea necesario. El alfa de Cronbach y el coeficiente omega permitirán analizar la consistencia interna mediante los valores de fiabilidad11.

El objetivo de este estudio fue crear una encuesta de opinión para participantes en simulaciones formativas, que fuera funcional y consistente mediante un proceso de validación.

Material y métodosDiseñoEl estudio se compuso de una fase cualitativa y una fase cuantitativa para la creación del instrumento y la obtención de evidencias para la validación del instrumento, que duró de 2022 a 2024 (fig. 1).

Todas las encuestas para expertos y participantes se crearon en la aplicación RedCap©, así como también la propia encuesta a validar. Se accedía a ellas por un código QR enviado por correo electrónico que, junto con la información sobre el objetivo del estudio, contenía un consentimiento informado que debía ser «aceptado» para poder responder las preguntas de los cuestionarios.

Procedimiento y análisis de datos fase cualitativaLa fase cualitativa tuvo 2 etapas: inicialmente se llevó a cabo el desarrollo de los apartados y preguntas de la encuesta por parte de un comité de docentes de la institución, expertos en aplicar metodología de simulación, cuya calidad de contenido fue evaluada por parte de un comité de expertos externo multidisciplinario estatal. Posteriormente, se sometió a la evaluación por parte de los participantes, población diana, respecto a la administración de esta herramienta de evaluación.

Etapas 1 y 2: obtención de evidencias de validez basadas en el contenido, de proceso de respuesta y de aplicación de la pruebaPara la primera etapa, durante el curso 2022–2023, profesoras universitarias, expertas en metodología de la simulación, crearon una encuesta para evaluar la opinión de los participantes en una simulación formativa, según su percepción del autoaprendizaje, la coherencia con el resto del programa docente, el proceso reflexivo, el rol del docente, la transferencia de conocimiento adquirido, la organización y la satisfacción de la sesión. La preparación inicial de su contenido se elaboró considerando la literatura científica. Se realizó una búsqueda bibliográfica en PubMed, Embase y Cochrane Database of Systematic Reviews, para los procesos de creación, depuración y análisis cuantitativo. La estrategia de búsqueda se realizó en español e inglés, con los descriptores «Encuestas» y «Cuestionarios», «Percepción», «Simulación» y «Opinión», «Psicometría», «Validación», «Perception», «Simulation», «Surveys» and «Questionnaires», «Psychometrics», «Validation Study», publicados en los últimos 10 años. Las fuentes halladas permitieron conocer el proceso de validación y el uso de métodos cualitativos y cuantitativos11. El método Delphi nos ayudó en las fases iniciales de la validación10, en las características idóneas que debe tener el redactado de las preguntas15 y el análisis psicométrico que debe aplicarse en la validación de encuestas unidimensionales5.

Se elaboró un listado de preguntas con el objetivo de incluir, inicialmente, todas las ideas surgidas. En consenso, los expertos del comité interno (n = 6) realizaron un proceso de depuración, eliminando preguntas repetidas o muy similares, generando un total de 61 preguntas, repartidas en 7 dominios para enmarcar a qué contexto se referían10. Cada miembro pudo escribir las modificaciones o comentarios para cada una de las preguntas en un archivo compartido, durante 2 semanas. Se redujo a un listado de 56 preguntas con 5 categorías de respuesta: «nada de acuerdo (1)», «poco de acuerdo (2)», «bastante de acuerdo (3)», «muy de acuerdo (4)», «totalmente de acuerdo (5)».

Los candidatos para el comité externo multidisciplinario estatal de expertos se seleccionaron bajo los siguientes criterios: no haber formado parte del comité creador de la encuesta, ser expertos en la metodología de simulación, y aceptar y firmar el consentimiento informado. De un listado de 25 personas, docentes de diferentes universidades españolas, 15 aceptaron la invitación mediante correo electrónico. Respondieron a un cuestionario Delphi sobre el contenido y el proceso de respuesta. Para cada pregunta, debían opinar sobre 3 aspectos, que eran: la pregunta ¿es representativa?, ¿responde al objetivo? y ¿es comprensible? Las respuestas eran categóricas (nada, poco, bastante, muy, totalmente de acuerdo).

Al mismo tiempo, se invitó a 10 estudiantes de tercer grado de Enfermería, del ámbito de estudio de la universidad, a responder la encuesta y, seguidamente, a opinar sobre ella, contestando las preguntas: «¿has tenido problemas de comprensión en algunas preguntas de la encuesta?» y «¿cuánto tiempo has tardado en leer y responder todas las preguntas?» Las respuestas dicotómicas sí/no, con condición de responder por qué, y una escala categórica de intervalos para el tiempo de respuesta (de 5–10 minutos; de 10–15 minutos; más de 15 minutos).

En una segunda etapa, con la nueva versión generada, se realizó una prueba piloto con 104 estudiantes de segundo grado de Enfermería del propio centro universitario. El análisis psicométrico inicial detectó la presencia de un efecto techo. La falta de variabilidad mostrada en la distribución de las respuestas impedía realizar un análisis de las propiedades psicométricas del instrumento (validez y fiabilidad). Se replanteó el redactado de las preguntas/ítems, con una revisión de los criterios de redacción según las recomendaciones, generando una nueva versión con 36 preguntas y 4 categorías de respuesta. La categoría intermedia fue retirada para eliminar tendencias de respuesta central.

A raíz de los resultados obtenidos, se realizó una segunda prueba piloto con 446 estudiantes, invitándoles, al finalizar una sesión de simulación, a responder la encuesta de 36 preguntas. Posteriormente, se pidió a los estudiantes que lo desearan, quedarse para participar en una sesión de focus group de unos 20 minutos de duración. En ella contestaron preguntas como: «¿os han parecido claros los enunciados de las preguntas?», «¿sabéis lo qué os preguntaban?», «¿se os ha hecho muy larga y pesada de contestar? ¿por qué?», «¿os ha parecido que alguna de las preguntas no se relacionaba con la simulación? ¿cuál y por qué?» Aceptaron participar un total de 35 estudiantes, en grupos de 5–8 personas, según el día en que se realizó la simulación.

Procedimiento y análisis de datos. Fase cuantitativa: trabajo de campo y análisis psicométricoEtapa 3: obtención de evidencias de validez respecto a la estructura internaSe procedió al análisis psicométrico de los resultados, del cual se realizó una depuración final de aquellos ítems que no presentaban propiedades favorables, por repetición o ambigüedad, corrigiendo los errores de método detectados por el comité interno de expertos, los cuales coincidían con las opiniones de los participantes en el focus group de estudiantes. Se eliminaron aquellas preguntas ambiguas y prescindibles que no afectaban la representatividad del constructo que se desea medir.

La versión final de la encuesta pasó a tener 24 preguntas, con 4 opciones de respuesta, cuyo análisis psicométrico se presenta a continuación.

El análisis de datos se realizó con el programa estadístico JASP (v. 18.2) de los 24 ítems que conformaban la escala, con un formato de respuesta tipo Likert de 4 opciones de respuesta (del 1 «nada de acuerdo» al 4 «totalmente de acuerdo»). Se obtuvieron, en primer lugar, los estadísticos descriptivos de los diferentes ítems del instrumento, que se muestran en los resultados. Se estudió la estructura interna de las puntuaciones de la encuesta, realizando un análisis factorial exploratorio. Se obtuvo, en primer lugar, una matriz de correlaciones, y se analizaron las condiciones de aplicación mediante la comprobación del coeficiente de Kaiser-Meyer-Olkin (KMO) mayor a 0,50 y de la prueba de esfericidad de Bartlett, estadísticamente significativa a nivel de 0,5. Se obtuvieron, posteriormente, el omega categórico (ω) y el alfa de Cronbach (α) y los estimadores del análisis factorial confirmatorio, de acuerdo con las recomendaciones de Doval et al.16,17, utilizando el estimador corregido de media y varianza de mínimos cuadrados ponderados (WLSMV), porque los datos eran ordinales (escala Likert de 4 puntos). Se consideraron los criterios clásicos al evaluar los índices de bondad de ajuste (GOFI): los valores superiores a 0,95 en TLI (Tucker-Lewis index) y CFI (Comparative fit index), y menores de 0,06 en RMSEA (Root Mean Error of Approximation), que se consideraron excelentes18, y los valores menores de 0,08 en RMSEA, se consideraron satisfactorios19.

Etapa 4: obtención de evidencias de validez respecto a otras variablesTambién se les pidió a los estudiantes que habían contestado la encuesta que respondieran una segunda encuesta control, ya validada19, que evaluaba los mismos conceptos, para obtener evidencias de validez de relación con otras variables de tipo convergente.

Etapa 5: fiabilidadSe estudió la fiabilidad de las puntuaciones del instrumento, evaluando la consistencia interna a través de los coeficientes alfa de Cronbach (α) y omega (ω)14. No se encontraron diferencias notables en la precisión de ambos coeficientes, pero sí se propuso, como buena práctica, la publicación conjunta de α y otros coeficientes alternativos20,21. Se consideraron aceptables valores a partir de 0,8 o de 0,7 en instrumentos en proceso de construcción.

ResultadosFases cualitativas y cuantitativasEtapas 1 y 2: resultados de las evidencias de validez basadas en el contenido, proceso de respuesta y aplicación de la pruebaLos resultados obtenidos de la Delphi de los 15 expertos externos y 10 estudiantes pueden consultarse en el material suplementario adjunto. Se calculó el porcentaje de respuestas de cada una de las 3 preguntas evaluadas, asociadas a las preguntas de la encuesta. Puntuaron del 1 al 5, en una escala de «nada de acuerdo; poco de acuerdo; bastante de acuerdo; muy de acuerdo; totalmente de acuerdo» para cada una de las preguntas de la encuesta a validar. Para el análisis, se crearon nuevas variables categóricas: «nada o poco de acuerdo», «bastante de acuerdo» y «muy o totalmente de acuerdo», siendo esta última la que se estimó en un 80% mínimo para otorgar la validez sobre el ítem preguntado10. En las puntuaciones entre el 60 y 80%, si afectaba a la comprensión, se reformuló el enunciado de las preguntas. En las puntuaciones menores del 60%, se eliminaron las preguntas. En las puntuaciones a partir del 80% del consenso, se dejó la pregunta igual. Un 80% de los estudiantes opinaron que no era pesado contestar, y que tardaron de 5 a 10 minutos en hacerlo.

Los resultados de la primera prueba piloto, con un total de 104 estudiantes que respondieron la encuesta en su versión de 56 ítems con 4 categorías de respuesta, mostraron que todos los ítems presentaban unas medianas de 5, y las medias se situaban a partir de 4,5 (efecto techo) con índices de asimetría y curtosis, indicando que los datos no poseían la variabilidad suficiente para poder ser analizados, desestimando continuar con los análisis.

En la segunda prueba piloto, respondieron a la encuesta de 36 ítems 446 estudiantes de distintas disciplinas académicas. Un total de 320 (71,75%) se identificaron con el género femenino, 116 (26%) masculino y 8 (1,80%) no binario. Respecto a la edad, un 30% tenían entre 18 y 20 años, un 60% entre 21 y 25 años, un 6,30% entre 26 y 30 años, y el resto, más de 30. Estudiantes del grado de Medicina, 179 (40%); de Fisioterapia, 129 (29%); 78 (17,50%) estudiantes de Enfermería y 43 (9,6%) estudiantes de Educación Infantil. Un grupo de 15 estudiantes eran de podología, prótesis dental y formación continuada. Respecto al rol de los estudiantes en la simulación, 165 (37%) lo hicieron solo como observadores de la escenificación; 262 (58,74%) como observadores y participantes, y 17 (3,8%) solo fueron participantes (tabla 1).

Distribución de los estudiantes según características sociodemográficas y académicas

| Características sociodemográficas y académicas | (n = 446) | |

|---|---|---|

| n | % | |

| Edad (años) | ||

| Entre 18 y 20 | 134 | 30,05 |

| Entre 21 y 25 | 268 | 60,09 |

| Entre 26 y 30 | 28 | 6,28 |

| Entre 31 y 35 | 5 | 1,12 |

| Entre 36 y 40 | 2 | 0,45 |

| Entre 41 y 45 | 4 | 0,9 |

| Entre 46 y 50 | 2 | 0,45 |

| Más de 50 | 2 | 0,45 |

| Missing | 1 | 0,22 |

| Sexo | ||

| Femenino | 320 | 71,75 |

| Masculino | 116 | 26,01 |

| No binario | 8 | 1,79 |

| Missing | 2 | 0,45 |

| Estudios | ||

| Medicina | 179 | 40,14 |

| Enfermería | 78 | 17,49 |

| Fisioterapia | 129 | 28,92 |

| Podología | 12 | 2,69 |

| Logopedia | 0 | 0 |

| Educación infantil | 43 | 9,64 |

| Administración de empresas | 0 | 0 |

| Máster o Posgrado | 0 | 0 |

| Curso de formación | 0 | 0 |

| Otro | 1 | 0,22 |

| Ninguno, ya soy profesional | 0 | 0 |

| Odontología | 0 | 0 |

| Prótesis dental | 2 | 0,45 |

| Missing | 2 | 0,45 |

| Rol | ||

| Observador | 165 | 37 |

| Observador y participante | 262 | 58,74 |

| Participante | 17 | 3,81 |

| Missing | 2 | 0,45 |

Participaron 35 estudiantes en el focus group, de los que obtuvimos un consenso respecto a que la encuesta era muy larga, y se cansaban de responder tantas preguntas, así como que había ítems ambiguos que generaban disparidad en la forma de entender la pregunta, entre los distintos participantes. Esto permitió detectar errores de método en 12 preguntas, que fueron eliminadas porque no afectaban a la representatividad del constructo.

Etapa 3: resultados de validez respecto a la estructura internaLa encuesta quedó configurada con 24 preguntas y 4 categorías de respuesta, en las que se pudo observar diversidad de puntuaciones (porcentaje mostrado en el material suplementario). Se presentan los valores obtenidos de la media con su desviación estándar (tabla 2), en lugar de la mediana, porque mostró un valor 4, que no reflejaba la diversidad mencionada.

Resumen de los estadísticos descriptivos de los ítems de la escala

| Ítems | Media | DS |

|---|---|---|

| aa_p1 Con esta sesión siento que he aprendido mucho con relación a la temática tratada | 3,645 | 0,541 |

| aa_p2 He sentido que se estaba poniendo en práctica los conceptos trabajados previamente en mi formación teórica | 3,637 | 0,547 |

| aa_p4 En esta sesión he podido identificar aquello que debo reforzar para ir avanzando en mi aprendizaje del tema | 3,617 | 0,56 |

| aa_p5 Recomendaría esta sesión a otros compañeros de mi ámbito formativo/profesional | 3,717 | 0,574 |

| co_p1 El global de la sesión ha sido coherente con todos los contenidos teóricos del tema, trabajados previamente | 3,656 | 0,534 |

| co_p4 El diseño del caso o los casos trabajados en la sesión, reflejaban fielmente, las posibles situaciones reales del tema tratado | 3,62 | 0,575 |

| co_p5 La reflexión conjunta ha sido siempre coherente con la finalidad de la sesión | 3,699 | 0,51 |

| pr_1 Compartir la opinión con mis compañeros de grupo me ha sido extremadamente útil para cuestionarme mis propias actuaciones | 3,578 | 0,627 |

| pr_2 La discusión de grupo me ha permitido identificar maneras de mejorar mi práctica académica o profesional | 3,661 | 0,553 |

| pr_4 Las reflexiones aportadas por mis compañeros de grupo han ampliado mi visión de cómo puedo interactuar con relación al tema tratado en una situación similar | 3,605 | 0,582 |

| rd_1 El docente me ha guiado siempre a través del objetivo de la simulación | 3,681 | 0,594 |

| rd_2 Los mensajes recibidos del docente ha sido clarificadores para que aprenda | 3,717 | 0,55 |

| rd_3 El docente me ha facilitado ver la importancia de las actuaciones observadas en la simulación | 3,736 | 0,516 |

| rd_4 El docente ha establecido un ambiente de confianza para fomentar una experiencia de aprendizaje participativa | 3,729 | 0,528 |

| rd_6 El docente ha utilizado ejemplos que me han facilitado la comprensión del tema | 3,695 | 0,542 |

| rd_7 El docente ha mostrado un gran interés en resolver las dudas de los participantes | 3.762 | 0,494 |

| tf_1 Haber asistido a esta sesión me ha permitido detectar los errores que debo evitar en la formación o la práctica del tema tratado | 3,708 | 0,533 |

| tf_2 La sesión me ha permitido imaginar cómo actuaré en un futuro, en mi formación o práctica del tema | 3,685 | 0,554 |

| tf_4 Los conocimientos teóricos de la temática tratada son totalmente aplicables a la práctica | 3,646 | 0,596 |

| tf_5 Con esta sesión he identificado nuevos aspectos, del tema tratado, que podré incorporar en mi forma de afrontar esta situación | 3,659 | 0,558 |

| or_1 Los tiempos de las diferentes fases de la sesión me han parecido muy adecuados | 3,521 | 0,712 |

| or_3 He recibido la documentación informativa con suficiente antelación para prepararme para esta sesión | 3,553 | 0,694 |

| or_4 El montaje de la escenificación me ha facilitado mucho el sentirme inmerso en lo que pasaba | 3,586 | 0,626 |

| or_5 Los materiales utilizados durante la sesión han sido clave para el buen funcionamiento de la simulación | 3,639 | 0,602 |

aa = autoaprendizaje, co = coherencia, pr = proceso reflexivo, rd = rol del docente, tf = transferencia, or = organización.

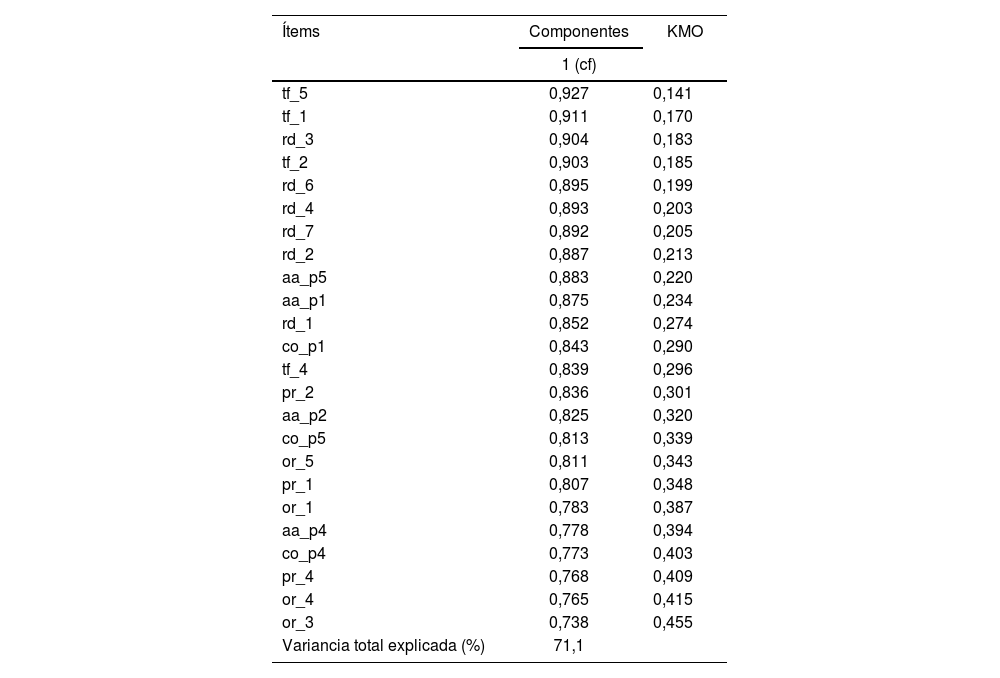

Antes de realizar el análisis factorial exploratorio, se analizaron las condiciones de aplicación. Los resultados confirmaron que los datos son factorizables (KMO rango 0,87–0,96; Bartlett χ2 = 14,903,56; d.f. = 276; p < 0,001), mostrados en la tabla 3. El análisis paralelo aconseja que la mejor solución es un modelo unidimensional, explicado con un 71,1% de la variancia total22. Las cargas factoriales son altas (rango 0,738 – 0,927). Los resultados para el análisis factorial confirmatorio muestran que el modelo obtuvo un buen ajuste a los datos de la muestra, de acuerdo con los índices empleados, como muestra la figura 2. Los valores obtenidos están resumidos en la tabla 4 (χ2 = 123,936 [p < 0,001], d.f. = 48,67; RMSEA = 0,00; CFI = 1,00; TLI =1,00)23.

Análisis factorial exploratorio de la versión final (24 ítems) del cuestionario, matriz de cargas factoriales, KMO y variancia total

| Ítems | Componentes | KMO |

|---|---|---|

| 1 (cf) | ||

| tf_5 | 0,927 | 0,141 |

| tf_1 | 0,911 | 0,170 |

| rd_3 | 0,904 | 0,183 |

| tf_2 | 0,903 | 0,185 |

| rd_6 | 0,895 | 0,199 |

| rd_4 | 0,893 | 0,203 |

| rd_7 | 0,892 | 0,205 |

| rd_2 | 0,887 | 0,213 |

| aa_p5 | 0,883 | 0,220 |

| aa_p1 | 0,875 | 0,234 |

| rd_1 | 0,852 | 0,274 |

| co_p1 | 0,843 | 0,290 |

| tf_4 | 0,839 | 0,296 |

| pr_2 | 0,836 | 0,301 |

| aa_p2 | 0,825 | 0,320 |

| co_p5 | 0,813 | 0,339 |

| or_5 | 0,811 | 0,343 |

| pr_1 | 0,807 | 0,348 |

| or_1 | 0,783 | 0,387 |

| aa_p4 | 0,778 | 0,394 |

| co_p4 | 0,773 | 0,403 |

| pr_4 | 0,768 | 0,409 |

| or_4 | 0,765 | 0,415 |

| or_3 | 0,738 | 0,455 |

| Variancia total explicada (%) | 71,1 |

aa = autoaprendizaje; co = coherencia; pr = proceso reflexivo; rd = rol del docente; tf = transferencia; or = organización; cf: matriz de cargas factoriales; KMO: coeficiente de Kaiser-Meyer-Olkin.

Índices de ajuste en modelos ajustados al análisis factorial confirmatorio

| Modelo | X2 | d,f | CFI | p | TLI | RMSEA |

|---|---|---|---|---|---|---|

| 1 factor | 123,936 | 48,67 | 1,00 | <0,001 | 1,00 | 0,00 |

χ2: chi-cuadrado; df: grados de libertad; CFI: índice de ajuste comparativo; TLI: índice de Tucker-Lewis; RMSEA: raíz del error cuadrático medio de aproximación.

En la relación con otras variables de tipo convergente, una parte de la muestra (n = 231) accedió a responder a una encuesta control, la «Encuesta de calidad y satisfacción de simulación clínica en estudiantes de Enfermería de Durá Ros (Padilla, et al.)»19, que también evalúa la «opinión/percepción/satisfacción» y que ha demostrado tener buenas propiedades psicométricas (α = 0,924). Se correlacionaron las puntuaciones de nuestra encuesta con las obtenidas en la encuesta control. Los resultados indican evidencia favorable de validez convergente, ya que las correlaciones obtenidas de ambos instrumentos son altas (r = 0,7).

Etapa 5: resultados de validez respecto a la fiabilidadSe estudió la fiabilidad de nuestro instrumento a través del estudio de la consistencia interna de sus puntuaciones. Se obtuvo el coeficiente alfa de Cronbach[17], así como también, complementariamente, omega. Ambos se consideraron excelentes (α = 0,963 [0,957–0,967]; ω = 0,963 [0,955–0,970]).

DiscusiónCrear instrumentos para la valoración educativa debe realizarse en torno a la calidad docente24. Los instrumentos validados de evaluación ocupan un lugar muy importante en la enseñanza y son claves para conocer el grado de formación de los estudiantes en las competencias de aprendizaje que deben aplicarse en un entorno real1. La diversidad de intereses docentes hace que surjan inquietudes que llevan a crear instrumentos para medir la opinión, la percepción o satisfacción de aquellos que son objeto directo de tal enseñanza6.

El método científico proporciona los mecanismos para entender cómo y cuándo puede ser evaluado un instrumento para determinar que es factible y fiable en aquello que se desea medir13. Si se quiere ser riguroso, todas las etapas del proceso son importantes y no excluyentes11.

Nuestro estudio de validación de una encuesta para valorar la eficacia de una sesión de simulación por los participantes ha tenido componentes cualitativos y cuantitativos, y ha seguido un proceso de fases consecutivas que han ido fortaleciendo las propiedades psicométricas de la encuesta final.

La fase cualitativa del estudio sentó las bases conceptuales de la encuesta. El instrumento permitió a los participantes opinar sobre aspectos relacionados con el autoaprendizaje, la coherencia, el proceso reflexivo, el rol del docente, la transferencia y la organización, al finalizar la sesión. Tan importante es que el instrumento creado obtuviera unos buenos valores psicométricos, como que permitiera conocer el impacto de la simulación13.

Coincidimos con la literatura en que al crear una nueva una encuesta, no por ser experto se está exento de cometer errores. Cuando se está implicado en el proceso de redactado durante un período largo de tiempo puede llevar a no hacerse preguntas o sorprenderse ante frases mal construidas, tecnicismos, ambigüedades u otros6.

Otro aspecto es que, en un proceso de validación, no podemos quedarnos únicamente con la opinión de un comité de expertos11. Su visión es muy importante, pero puede estar sesgada por una experiencia concreta11,12. La opinión de los sujetos, objeto directo de la encuesta, los estudiantes, permitió detectar limitaciones que, no por ser obvias, se detectaron en un principio, y se evidenciaron preguntas que preguntaban algo muy similar a otras y que no habían sido detectadas por los expertos. También permitió prescindir de otras que se alejaban del objetivo de la encuesta, eran demasiado largas o presentaban una complejidad gramatical que dificultaba la comprensión3.

La encuesta final obtenida permitió realizar un análisis psicométrico válido para demostrar su funcionalidad. El análisis exploratorio determinó que se cumplía la unidimensionalidad, con una muy buena puntuación (71%), demostrando que todas las preguntas del constructo, repartidas en distintas dimensiones, tienen una variable común de fondo4.

La correlación con las respuestas de otra encuesta similar validada permitió verificar la fortaleza del instrumento (r = 0,7) mediante la evaluación de los constructos similares entre las 2 encuestas. Así como la validez discriminante, para confirmar que evalúa lo que quiere conocer y no otro constructo11.

La consistencia interna fue muy alta (α = 0,930), pudiendo hacer pensar que hay demasiado coincidencia entre las preguntas de la encuesta. Este dato reafirma la necesidad de no basar el proceso de validación con criterios únicamente psicométricos, que pueden restar valor cuando los constructos están creados para recoger las opiniones subjetivas de las personas14.

El uso de la encuesta validada permitirá obtener una opinión fiable de los participantes para calibrar las simulaciones ya consolidadas y nuevas. Disponer de instrumentos validados propios permitirá seguir aportando datos sobre su validez convergente cuando se utilice en simulaciones de otras disciplinas académicas, donde todavía no ha sido probada10, y evaluar la introducción de innovaciones o adaptaciones, ya que la enseñanza evoluciona con el tiempo.

Responsabilidades éticasLos autores declaran que los estudiantes en todo momento conocieron la información y pudieron abandonar el estudio en cualquier momento, sin repercusión en sus expedientes. Antes de contestar a las encuestas, el sistema informático de gestión les mostró un consentimiento, que los estudiantes debían de aceptar para poder entrar en la sala y resolver el caso (anexo 1). Se consideró la ley orgánica 3/2018 de protección de datos personales y garantía de los derechos digitales.

FinanciaciónLos autores declaran que esta investigación no recibió ninguna subvención específica de agencias de financiación en los sectores público, comercial o sin fines de lucro.

Conflicto de interesesTodos los autores declaran que no tienen conflictos de intereses.

AgradecimientosAgradecer a toda la Comisión de Simulación de UManresa de los grados de Medicina, Enfermería, Fisioterapia, Educación Infantil, Podología y Logopedia, por su plena implicación en el proyecto. Su colaboración, especialmente en el trabajo de campo, ha sido indispensable. Y al equipo del CISARC y la Catedra de Simulación y Seguridad del Paciente, fundamental en la creación de la base que permitió el desarrollo de este estudio.

Presentación en congresosParte del contenido ha sido presentado como comunicación oral en el XI CONGRESO DE LA SOCIEDAD ESPAÑOLA DE SIMULACIÓN CLÍNICA Y SEGURIDAD DEL PACIENTE, Asturias 18–20 de abril del 2024.

Este estudio se sitúa en el marco de una tesis doctoral que la doctoranda Aida Camps-Gómez está llevando a cabo en la Universidad de Vic UVIC-UCC.

Se puede consultar material adicional a este artículo en su versión electrónica disponible en: https://doi.org/10.1016/j.edumed.2025.101064.