Aunque el formato de examen clínico objetivo estructurado (ECOE) se aplica en Uruguay desde 2004 proveyendo medidas confiables de rendimiento, las percepciones sobre sus propiedades y el grado de satisfacción estudiantiles no han sido exploradas.

ObjetivoLa siguiente experiencia estuvo dirigida a evaluar la validez aparente del ECOE como aporte al estudio de su factibilidad local.

Material y métodosAl final del ciclo propedéutico, la subcohorte cursando en el Hospital Universitario contestó un cuestionario de 28 ítems dirigido a explorar las percepciones sobre las propiedades del ECOE en los potenciales factores «diseño» y «validez aparente». Tras analizar su confiabilidad, se depuró el formulario para proveer una herramienta más breve y fiable.

ResultadosEl cuestionario original mostró una confiabilidad aceptable (alfa de Cronbach=0,70), dominando las opiniones de «acuerdo/total acuerdo» sobre autenticidad de los estímulos, dinámica, pertinencia y justicia del examen. Los estudiantes percibieron obstáculos organizativos durante la prueba, manifestando desacuerdo en incluir alguna estación dirigida a evaluar solamente habilidades para la comunicación y requiriendo instancias de devolución (feedback) personalizada. La versión depurada del cuestionario original provee medidas consistentes sobre las percepciones estudiantiles y resulta una herramienta útil que podría aplicarse extensamente. Se discuten los aportes de esta experiencia al estudio de la factibilidad del nuevo formato durante la transición curricular.

ConclusionesEl ECOE es bien evaluado por los estudiantes al final del ciclo propedéutico, lo que apoya su validez. Deben aprovecharse sus potenciales formativos proveyendo feedback efectivo a estudiantes, tutores clínicos e institución.

Although an objective structured clinical examination (OSCE) format has been applied in Uruguay since 2004, and providing reliable performance measures, perceptions of it properties and level of student satisfaction have not been determined.

ObjectiveTo evaluate the face validity of OSCE format as a contribution to its local feasibility study.

Material and methodsAt the end of the introductory clinical course, the sub-cohort enrolled at the University Hospital responded to a 28-item questionnaire aimed at exploring perceptions about the properties of the OSCE about the potential factors ‘design’ and ‘apparent validity’. After analysing the reliability of the original questionnaire, the questionnaire was refined in an attempt to provide a shorter and more reliable tool.

ResultsThe original questionnaire showed good internal consistency (Cronbach alpha=0.70), with a dominance of ‘agreement/total agreement’ opinions on authenticity of the stimuli, dynamic, relevance, and equity of the test. Students perceived organisational obstacles during the test, expressing disagreement to include some stations only aimed at assessing communication skills, and requiring personalised feedback sessions. The refined version of the questionnaire provides consistent measures on student perceptions and is a useful tool that can be widely applied. A discussion is presented on the contributions of this experience to a comprehensive feasibility study of the new format during curriculum transition.

ConclusionsThe OSCE is well evaluated by students at the end of the propaedeutic course, supporting its validity. Educational potentials of the new format should be exploited, providing effective feedback to students, clinical teachers, and institutions.

El examen clínico objetivo estructurado (ECOE) evalúa aspectos de la competencia clínica de manera objetiva, reportando buenos índices de validez y confiabilidad desde sus primeras experiencias1. Sus fortalezas lo han llevado a ser utilizado en múltiples disciplinas, tanto a nivel de grado como en pruebas de certificación de fin de carrera y posgrado2,3. Este formato de evaluación —que constituye una simulación de escenarios de trabajo— verifica la competencia en habilidades clínicas múltiples y dirige el aprendizaje en áreas insuficientemente evaluadas. A su vez, ha sido bien aceptado por los examinandos4 y posibilita la devolución (feedback) al candidato en relación con su rendimiento5.

La validez aparente de un test es un constructo multidimensional que explica de qué manera los ítems de un formato de prueba resultan ante los individuos involucrados en su construcción y aplicación6,7. En la práctica, esta validez se estima con base en la información aportada por opiniones de examinandos, examinadores y expertos, por lo que puede ser considerada una medida de credibilidad, aceptación y factibilidad en su aplicación. Aunque la literatura internacional reporta datos aceptables sobre la detección de las propiedades y el grado de satisfacción estudiantiles con el ECOE8-10, estos resultados no han sido replicados en la región. Además, como el estudiante se expone a lo desconocido ante un nuevo formato de prueba, pueden agregarse componentes de ansiedad-estrés que induzcan sesgos en los resultados11,12.

En 2002 y 2003, en el marco de un proyecto de colaboración con el Centro de Evaluación de las Ciencias de la Salud de la Universidad de Laval (Québec, Canadá), se asistió a un seminario sobre evaluación de la competencia médica y un taller formativo sobre la construcción del ECOE. Esto estimuló al ensayo del primer ECOE al final del Ciclo de Introducción a la Medicina Integral (CIMI, ciclo propedéutico) del 4.o año de la carrera, sustituyendo al tradicional examen con uno o dos «caso/s largo/s» reales13. En 2005, la Facultad de Medicina se presentó voluntariamente al Mecanismo Experimental de Acreditación regional de carreras universitarias para el bloque Mercosur, Bolivia y Chile. Desde entonces, la necesidad de cumplir estándares regionales de calidad educativa obligó a ensayar y validar instrumentos con buenas propiedades métricas y factibles de utilizarse en un continuum. Desde 2007, el ECOE se consolida como el formato único de evaluación final en los ciclos clínicos de adultos (4.o-6.o año de la carrera de grado).

Las experiencias regionales aplicando el ECOE han demostrado buena aceptación y confiabilidad e impactos educativos variables14-16. Sin embargo, su aplicación en Uruguay aún representa un desafío. Sin pretender ser la experiencia descrita en series internacionales, el que sigue y otros análisis son parte del ensayo empírico con un formato que requiere ajustes al contexto educativo y social local. En cierto modo, la aplicación del ECOE a nivel de grado en Uruguay ha representado un motor de cambio que, además de proveer medidas de rendimiento confiables, aporta una perspectiva analítica sobre la efectividad en la aplicación del currículo. La siguiente experiencia estuvo dirigida a evaluar las percepciones estudiantiles sobre las propiedades del ECOE en sus primeras instancias de ensayo. Durante la puesta en marcha de un nuevo Plan de Estudios, la experiencia también pretendió disponer una herramienta válida y confiable para evaluar las opiniones de los candidatos en instancias futuras.

Material y métodosEl ciclo propedéutico Introducción a la Medicina IntegralEn el Plan de Estudios vigente, durante el segundo tercio del 4.o año en una carrera de 8 años, los estudiantes iniciaron su entrenamiento en habilidades para la entrevista, examen físico y actitudes comunicacionales en ambiente hospitalario. La mitad de la cohorte cursó en el Hospital Universitario y la otra en el Hospital Maciel. En el CIMI, el 60% del tiempo lectivo se focalizó en encuentros clínicos con pacientes reales internados, el 20% en lecturas y el otro 20% en actividades de aprendizaje en grupos pequeños. Tras alcanzar un mínimo de rendimiento, toda la cohorte rindió la evaluación de fin de curso en formato ECOE.

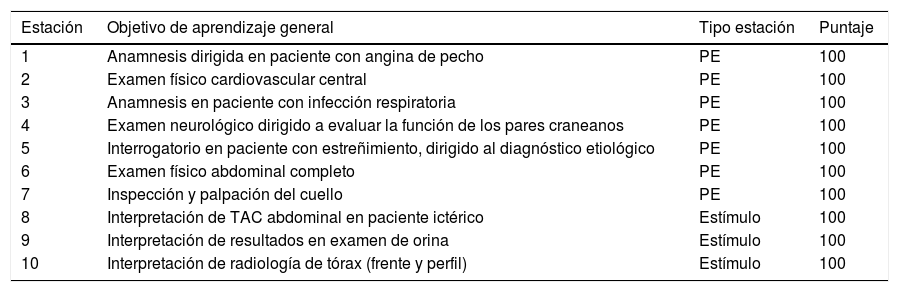

El examen final en formato examen clínico objetivo estructuradoLa duración del ECOE fue de 70min (10 estaciones de 7min, tabla 1). Se evaluaron 498 estudiantes en 9 circuitos paralelos. Los pacientes estandarizados (PE) eran actores profesionales previamente entrenados. El examen transcurrió simultáneamente en las instalaciones de dos centros de atención terciaria con capacidad locativa y medios de contralor adecuados (Hospital Universitario y Hospital Maciel). Un comité de examen ad hoc fue designado para construir y ejecutar la prueba. Los coordinadores, supervisores de circuitos y examinadores tenían un mínimo de experiencia en tutorías clínicas de 2 años. Las garantías en la validez de contenido y construcción de las grillas de evaluación específicas de caso para cada estación fue responsabilidad del comité de examen. Los examinadores llenaron una grilla con la lista de ítems en forma dicotómica («hecho/no hecho») y marcaron su opinión sobre el rendimiento global del estudiante en una escala de Likert 1-4 (1: claramente insuficiente; 2: dudoso; 3: claramente suficiente, 4: superior). En las semanas previas al examen se difundió el funcionamiento de un ECOE prototipo (ya explicado al inicio del curso), incluyendo aspectos de dinámica-logística, y se informó a los integrantes de la subcohorte del Hospital Universitario sobre las características y objetivos del cuestionario anónimo a responder tras la prueba.

Estructura del ECOE al final del ciclo propedéutico (CIMI)

| Estación | Objetivo de aprendizaje general | Tipo estación | Puntaje |

|---|---|---|---|

| 1 | Anamnesis dirigida en paciente con angina de pecho | PE | 100 |

| 2 | Examen físico cardiovascular central | PE | 100 |

| 3 | Anamnesis en paciente con infección respiratoria | PE | 100 |

| 4 | Examen neurológico dirigido a evaluar la función de los pares craneanos | PE | 100 |

| 5 | Interrogatorio en paciente con estreñimiento, dirigido al diagnóstico etiológico | PE | 100 |

| 6 | Examen físico abdominal completo | PE | 100 |

| 7 | Inspección y palpación del cuello | PE | 100 |

| 8 | Interpretación de TAC abdominal en paciente ictérico | Estímulo | 100 |

| 9 | Interpretación de resultados en examen de orina | Estímulo | 100 |

| 10 | Interpretación de radiología de tórax (frente y perfil) | Estímulo | 100 |

Se presenta la tabla de especificaciones de todo el examen.

CIMI: Ciclo de Introducción a la Medicina Integral; ECOE: examen clínico objetivo estructurado; PE: paciente estandarizado.

El cuestionario completo estuvo constituido por 51 ítems:

- •

2 ítems demográficos: género y edad;

- •

28 ítems: percepciones estudiantiles sobre las propiedades del ECOE (ver anexo en el material suplementario)10,17;

- •

12 ítems: versión en español del General Health Questionnaire (GHQ-12) (Goldberg, 1978; García Viniegras, 1999), y

- •

9 ítems: síntomas de ansiedad-estrés.

La subcohorte de estudiantes que cursó y rindió el examen en el Hospital Universitario (258 estudiantes) respondió el cuestionario al finalizar el ECOE, sin límites de tiempo para ser completado. Los investigadores estimaron que podría ser respondido en 20-25min. En 25/28 ítems del cuestionario destinado a evaluar las percepciones sobre las propiedades del ECOE, los estudiantes respondieron en una escala de satisfacción (Likert) de 1 a 5, donde 0: sin respuesta; 1: en total desacuerdo; 2: en desacuerdo; 3: sin opinión; 4: de acuerdo; y 5: de total acuerdo. En 3 ítems respondieron mediante una respuesta abierta breve.

Análisis estadísticoSe presentan las estadísticas descriptivas de los puntajes en los ítems referidos a las percepciones en medias y DE. La confiabilidad del cuestionario se estimó mediante el coeficiente de confiabilidad alfa de Cronbach. El poder discriminante de cada ítem con respuesta en escala de Likert se evaluó mediante índices de correlación ítem-total, presentando los índices de confiabilidad referentes a los factores de un potencial modelo bifactorial, donde 16 ítems correspondían al factor (1) «diseño» y 12 al factor (2) «validez aparente», y para todo el cuestionario al eliminar cada ítem. Posteriormente se depuró el cuestionario original, eliminando aquellos ítems con baja pertinencia en el modelo y/o escaso poder discriminante. Cuando correspondiera, las opiniones en los ítems con respuesta abierta se compararon con las medias, mínimos y máximos puntajes de rendimiento estudiantil por estación. Los resultados se procesaron mediante el software SPSS, versión 15.0 (Microsoft Corp.).

ResultadosSe presentan los resultados de los 28 ítems que evaluaron las percepciones estudiantiles sobre las propiedades del ECOE (ver anexo en el material suplementario). Completaron el cuestionario 221 estudiantes (tasa de respuesta del 86%), 163 de ellos (73,80%) de sexo femenino. El 77,35% eran menores de 25 años, lo que incluye estudiantes de la cohorte sin rezago (45,00%) y estudiantes con retraso académico máximo de 3 años (media=23 años, DE=5,51). El cuestionario mostró un índice de consistencia interna alfa de Cronbach de 0,70.

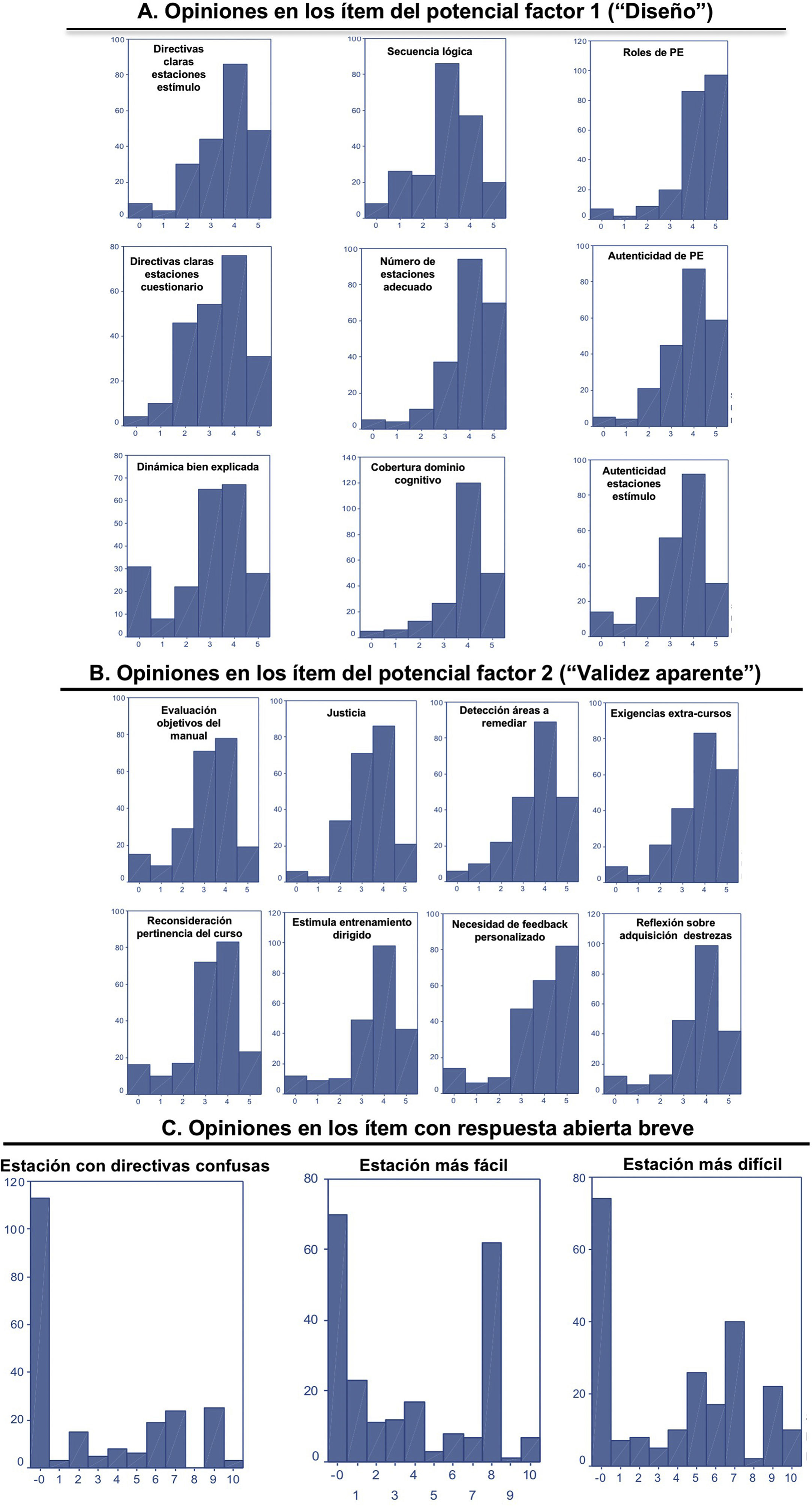

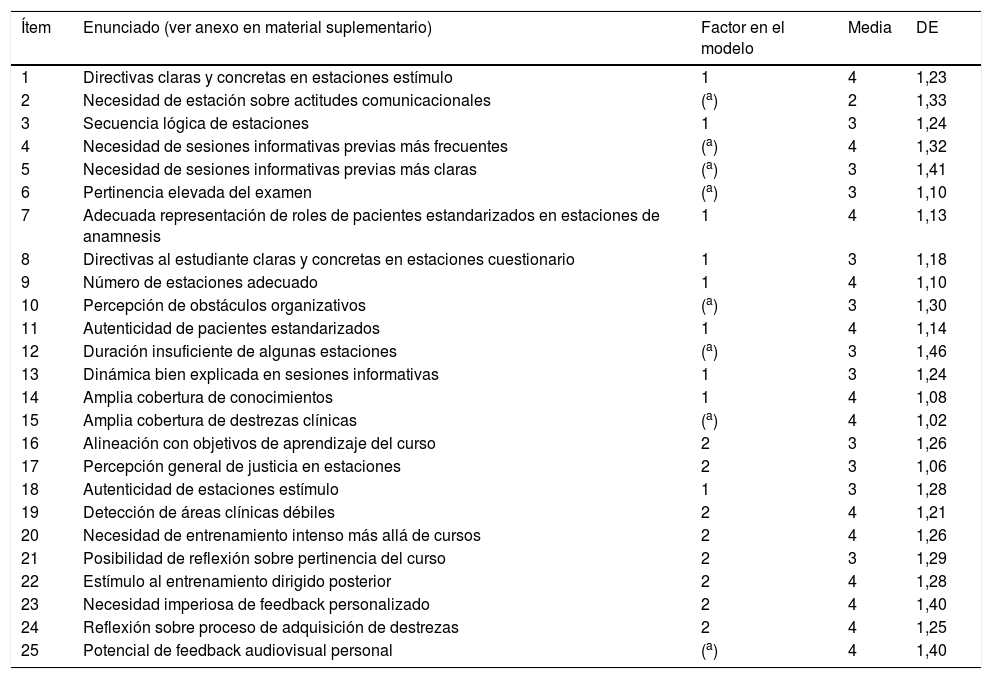

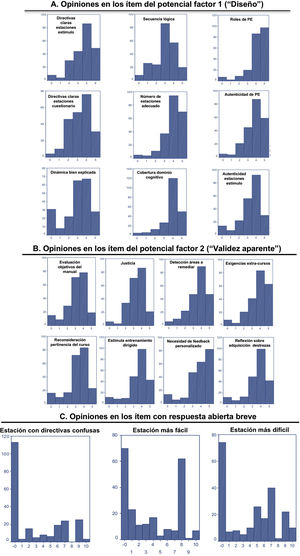

Las respuestas en los ítems en escala de Likert 1-5 se grafican en la figura 1 (paneles A y B). En relación con los ítems que exploran el potencial factor (1) del modelo («diseño»), hay total acuerdo sobre la claridad de las directivas en las estaciones estímulo, necesidad de sesiones informativas previas más frecuentes, adecuado cumplimiento de roles de los PE en las estaciones estímulo, autenticidad del estímulo en las estaciones con PE y cobertura amplia del examen en los dominios cognitivo y psicomotor. Hay acuerdo en la necesidad de sesiones informativas previas más claras, pertinencia de las estaciones, directivas claras y concretas en las estaciones estímulo con anamnesis e información provista durante los cursos sobre la dinámica del examen. Las situaciones planteadas en las estaciones estímulo se percibieron como auténticas, y se detectaron obstáculos organizativos durante el transcurso de la prueba. Hay desacuerdo en incluir alguna estación que evalúe exclusivamente habilidades para la comunicación. En relación con los ítems que exploran el potencial factor «validez aparente», los estudiantes expresan total acuerdo en que el ECOE permite detectar áreas a mejorar, estimula el entrenamiento dirigido luego del curso, permite reflexionar sobre el proceso de adquisición de las habilidades clínicas, y requiere contar con alguna instancia de feedback personalizado. Hay acuerdo en que el examen evalúa claramente los objetivos de aprendizaje específicos del curso, resulta una evaluación justa, exige un intenso entrenamiento clínico más allá de la carga horaria curricular y permite reconsiderar la pertinencia del curso. Se evidenció una baja tasa de respuesta en los ítems de respuesta abierta breve. La estación percibida como menos clara en sus directivas (estación 9) presentó baja capacidad de discriminación. Las percepciones sobre la dificultad de las estaciones con PE coinciden con los rendimientos demostrados; la estación 8, percibida como más fácil, exhibió el rendimiento estudiantil más elevado (83,1±14,0 puntos), y la considerada como más difícil (estación 7), exhibió el rendimiento más bajo (51,0±14,0 puntos; fig. 1, panel C). Procediendo a la depuración del cuestionario original, se excluyeron 11 ítems por su baja pertinencia con relación a los factores explorados y/o por su escaso poder discriminante; esto es, con coeficientes de correlación ítem-total menores de 0,20 (7 correspondientes a la «validez aparente» y 2 al «diseño», ver tabla 2), concluyendo en un cuestionario más breve (17 ítems) en que todos los ítems demostraban un coeficiente de correlación ítem-total mayor de 0,30. Esta versión demuestra índices de consistencia interna aceptables, tanto para la totalidad de los ítems como para los subconjuntos de ítems probablemente relacionados con ambos factores (tablas 3 y 4).

Opiniones en los ítems con respuesta en escala de Likert y con respuesta abierta breve. A) Opiniones en los ítems del potencial factor 1 («diseño»). Se presentan las opiniones tras depurar el cuestionario original. Domina la opinión «acuerdo»/«total acuerdo» en ítems del potencial factor 1. B) Opiniones en los ítems del potencial factor 2 («validez aparente»). Domina la opinión de «acuerdo»/«total acuerdo» en la mayoría de los ítems. Se manifiesta la necesidad de contar con instancias de devolución (feedback) personalizada. C) Distribución de las opiniones estudiantiles en los ítems de respuesta abierta breve. Las directivas de las estaciones 6, 7 y 9 fueron percibidas como «poco claras».

Opiniones de los estudiantes

| Ítem | Enunciado (ver anexo en material suplementario) | Factor en el modelo | Media | DE |

|---|---|---|---|---|

| 1 | Directivas claras y concretas en estaciones estímulo | 1 | 4 | 1,23 |

| 2 | Necesidad de estación sobre actitudes comunicacionales | (a) | 2 | 1,33 |

| 3 | Secuencia lógica de estaciones | 1 | 3 | 1,24 |

| 4 | Necesidad de sesiones informativas previas más frecuentes | (a) | 4 | 1,32 |

| 5 | Necesidad de sesiones informativas previas más claras | (a) | 3 | 1,41 |

| 6 | Pertinencia elevada del examen | (a) | 3 | 1,10 |

| 7 | Adecuada representación de roles de pacientes estandarizados en estaciones de anamnesis | 1 | 4 | 1,13 |

| 8 | Directivas al estudiante claras y concretas en estaciones cuestionario | 1 | 3 | 1,18 |

| 9 | Número de estaciones adecuado | 1 | 4 | 1,10 |

| 10 | Percepción de obstáculos organizativos | (a) | 3 | 1,30 |

| 11 | Autenticidad de pacientes estandarizados | 1 | 4 | 1,14 |

| 12 | Duración insuficiente de algunas estaciones | (a) | 3 | 1,46 |

| 13 | Dinámica bien explicada en sesiones informativas | 1 | 3 | 1,24 |

| 14 | Amplia cobertura de conocimientos | 1 | 4 | 1,08 |

| 15 | Amplia cobertura de destrezas clínicas | (a) | 4 | 1,02 |

| 16 | Alineación con objetivos de aprendizaje del curso | 2 | 3 | 1,26 |

| 17 | Percepción general de justicia en estaciones | 2 | 3 | 1,06 |

| 18 | Autenticidad de estaciones estímulo | 1 | 3 | 1,28 |

| 19 | Detección de áreas clínicas débiles | 2 | 4 | 1,21 |

| 20 | Necesidad de entrenamiento intenso más allá de cursos | 2 | 4 | 1,26 |

| 21 | Posibilidad de reflexión sobre pertinencia del curso | 2 | 3 | 1,29 |

| 22 | Estímulo al entrenamiento dirigido posterior | 2 | 4 | 1,28 |

| 23 | Necesidad imperiosa de feedback personalizado | 2 | 4 | 1,40 |

| 24 | Reflexión sobre proceso de adquisición de destrezas | 2 | 4 | 1,25 |

| 25 | Potencial de feedback audiovisual personal | (a) | 4 | 1,40 |

Puntajes obtenidos en los ítems del cuestionario con respuesta en escala Likert (1-5 puntos), en un potencial modelo bifactorial donde el factor (1) es «diseño» y el factor (2) es «validez aparente».

DE: desviación estándar.

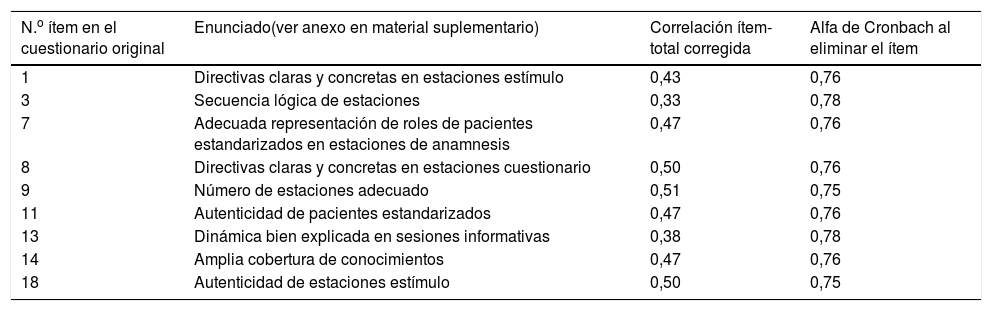

Resultados referentes al potencial factor (1): «Diseño»

| N.o ítem en el cuestionario original | Enunciado(ver anexo en material suplementario) | Correlación ítem-total corregida | Alfa de Cronbach al eliminar el ítem |

|---|---|---|---|

| 1 | Directivas claras y concretas en estaciones estímulo | 0,43 | 0,76 |

| 3 | Secuencia lógica de estaciones | 0,33 | 0,78 |

| 7 | Adecuada representación de roles de pacientes estandarizados en estaciones de anamnesis | 0,47 | 0,76 |

| 8 | Directivas claras y concretas en estaciones cuestionario | 0,50 | 0,76 |

| 9 | Número de estaciones adecuado | 0,51 | 0,75 |

| 11 | Autenticidad de pacientes estandarizados | 0,47 | 0,76 |

| 13 | Dinámica bien explicada en sesiones informativas | 0,38 | 0,78 |

| 14 | Amplia cobertura de conocimientos | 0,47 | 0,76 |

| 18 | Autenticidad de estaciones estímulo | 0,50 | 0,75 |

Se presentan los puntajes con sus índices de discriminación y los valores del coeficiente de confiabilidad alfa del cuestionario depurado al eliminar cada ítem. El alfa de Cronbach de los ítems del factor es de 0,78.

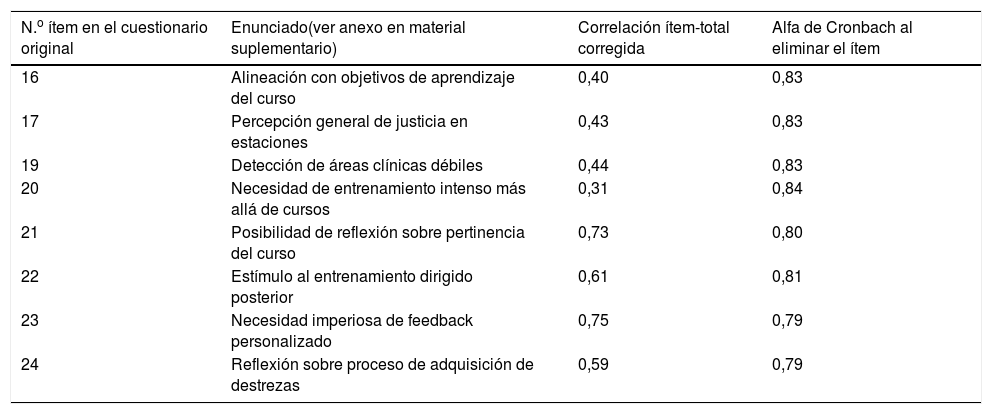

Resultados en el potencial factor (2): «Validez aparente»

| N.o ítem en el cuestionario original | Enunciado(ver anexo en material suplementario) | Correlación ítem-total corregida | Alfa de Cronbach al eliminar el ítem |

|---|---|---|---|

| 16 | Alineación con objetivos de aprendizaje del curso | 0,40 | 0,83 |

| 17 | Percepción general de justicia en estaciones | 0,43 | 0,83 |

| 19 | Detección de áreas clínicas débiles | 0,44 | 0,83 |

| 20 | Necesidad de entrenamiento intenso más allá de cursos | 0,31 | 0,84 |

| 21 | Posibilidad de reflexión sobre pertinencia del curso | 0,73 | 0,80 |

| 22 | Estímulo al entrenamiento dirigido posterior | 0,61 | 0,81 |

| 23 | Necesidad imperiosa de feedback personalizado | 0,75 | 0,79 |

| 24 | Reflexión sobre proceso de adquisición de destrezas | 0,59 | 0,79 |

Se presentan los puntajes con sus índices de discriminación y valores del coeficiente de confiabilidad alfa del cuestionario depurado al eliminar cada ítem. El coeficiente alfa de Cronbach de los ítems del factor es de 0,83.

Esta aproximación al análisis de las percepciones estudiantiles frente al nuevo formato refleja buen grado de aceptación con relación a dos de sus potenciales facetas o dimensiones, validando los resultados descritos por Russell et al.10 y De Lisle17. El cuestionario depurado, más breve que aquel original, provee medidas consistentes. En general se observan opiniones favorables en relación con diversas propiedades críticas del formato4-9,11,12. Estos resultados se asemejan a los obtenidos por Imani y Tabatabaie en lo referente a transparencia, justicia y autenticidad12. Sorprende que los estudiantes no requieran ser evaluados más en profundidad en algunas habilidades para la comunicación médico-sujeto de estudio, al menos en este nivel de entrenamiento clínico. Con respecto a la implementación del examen, los estudiantes solicitan mayor duración de las estaciones y más sesiones informativas previas. Aunque exigen claridad en las directivas de estas, acuerdan que la dinámica del examen fue bien informada y requieren instancias de devolución (feedback) personalizada, incluso mediante técnicas audiovisuales. Esta necesidad adquiere gran importancia, pues su implementación sistemática ha sido bien recibida por los examinandos5,8. La escasa claridad de las sesiones explicativas podría deberse, en parte, a la carencia de objetivos de aprendizaje específicos como resultados esperados del aprendizaje, pues el Manual de Objetivos fue provisto tardíamente. Como estimación de la capacidad de autoevaluación, la dificultad relativa de los «casos» en las estaciones con PE se percibió en forma fidedigna. La imposibilidad de acceder a las trayectorias curriculares impidió un análisis exhaustivo en cada subcohorte.

El cuestionario ensayado aporta información útil al análisis de factibilidad del ECOE en nuestra institución, una Escuela de Medicina estatal que aún manifiesta resistencias a la implantación de nuevas herramientas de evaluación clínica. En un escenario de recursos limitados, la factibilidad de aplicar ámbitos de simulación requiere un análisis profundo que incluya un estudio de costos18. Poenaru et al. reportaron un costo promedio de 70 dólares americanos por estudiante en un examen de 18 estaciones de 6min19. En Uruguay, Macri et al. estimaron que se requerían casi 30 dólares americanos por estudiante para correr un ECOE de 16 estaciones, detectando deficiencias en logística-infraestructura y la necesidad de recursos humanos experimentados para apoyar la gestión pre, intra y postexamen20. Además, la experiencia del ECOE transforma a los estudiantes en partícipes activos a la hora de aplicar metodologías e instrumentos de evaluación durante sus rotaciones clínicas21, en una institución con representación estudiantil en sus organismos de administración. Otros aspectos que aportan a este complejo análisis de factibilidad local —como la necesidad de mejorar la logística e infraestructura, la comparación de costos con otros formatos, la disponibilidad de PE, y el grado de entrenamiento de los examinadores, por ejemplo— ya han sido evaluados por el Departamento de Educación Médica. A pesar de existir una buena correlación entre la percepción de dificultad con los rendimientos en algunas estaciones, el escaso número de ítems basados en la autoevaluación hacen que esta información sea poco generalizable. La aplicación del cuestionario en una de las subcohortes de estudiantes es una limitante de nuestra experiencia, más aun sabiendo que algunas diferencias de contexto educativo y asistencial entre centros podrían asociarse con rendimientos diferentes. De todas maneras, la experiencia provee elementos suficientes para aplicarla con mínimas garantías de validez a toda la cohorte de estudiantes y en otros cursos clínicos. Desgraciadamente, el gran potencial formativo de las instancias que utilizan PE parece no haberse percibido claramente en la región, donde el ECOE ha sido adoptado más como una instancia de evaluación sumativa para tomar decisiones de «pasa-no pasa» que como oportunidad formativa. Esta es una diferencia sustancial con otros medios que limita la herramienta. Ya en la década de los 90, más del 70% de las Escuelas de Medicina de Estados Unidos y Canadá incluían instancias de feedback formal con el uso de PE22. Es necesario proveer una devolución a los tutores sobre los rendimientos e instancias de feedback personalizado a los candidatos, al menos en las áreas de rendimiento débil y en quienes reprueban o se sitúan en la «zona gris».

ConclusionesEl cuestionario de satisfacción demostró buenas propiedades métricas, dando solidez a los resultados obtenidos con su aplicación original10 y habilitando una revisión más extensa de las opiniones estudiantiles acerca del ECOE en Uruguay. Así, las percepciones sobre otras pruebas en dicho formato pueden evaluarse con buena confiabilidad mediante un cuestionario depurado, breve y de buena aceptación, durante la transición curricular. Queda pendiente proceder a un análisis factorial confirmatorio que aporte solidez adicional al cuestionario.

Como conceptos básicos destacan: a) las percepciones estudiantiles sobre las propiedades del nuevo formato ECOE no han sido evaluadas en Uruguay; b) al final del curso propedéutico, los estudiantes están de acuerdo sobre la autenticidad de los estímulos, dinámica, pertinencia y justicia del ECOE; c) se dispone un cuestionario válido que puede aplicarse durante la transición curricular, contribuyendo al análisis de su factibilidad local.

Conflicto de interesesNinguno.

Al Dr. Carlos Brailovsky (CESSUL, Laval) por su generosidad académica y su apoyo incondicional durante la puesta en marcha del ECOE en Uruguay. Al entonces Decano Dr. Felipe Schelotto y a los estudiantes que participaron en la experiencia.