Este artículo de opinión pretende contribuir al debate sobre cómo se debe valorar la calidad de los investigadores, revistas y países en su producción científica. Este debate, lejos de estar aclarando los términos en los que deben basarse las diferentes comisiones que juzgan la trayectoria científica de investigadores, profesores universitarios, revistas profesionales y de investigación, e incluso comunidades autónomas y países, está creando mayor confusión, sobre todo entre los más afectados, los investigadores españoles e iberoamericanos y las revistas de sus países, que tienen que competir contra la potente maquinaria editorial anglosajona1-23. Se repite una vez más el combate entre unos david y goliat científicos con resultados muy diferentes al referido en los textos bíblicos.

Quien más, quien menos, todos nos hemos sentido alguna vez preocupados o, por lo menos, afectados por algún tipo de evaluación de nuestra trayectoria científica, bien al solicitar la subvención de un proyecto de investigación a cualquiera de las instituciones públicas autonómicas, nacionales o supranacionales bajo supervisión de agencias como la Agencia Nacional de Evaluación y Prospectiva (ANEP), al optar a los denominados "sexenios" ante la Comisión Nacional Evaluadora de la Actividad Investigadora (CNEAI), los complementos de productividad de comunidades autónomas, o al concursar por una plaza de investigador en algún centro prestigioso o de profesor universitario después de obtener la acreditación por la Agencia Nacional de Evaluación de la Calidad y Acreditación (ANECA).

Es evidente que estas preocupaciones afectan a la felicidad del investigador, felicidad que debe ser un objetivo a perseguir si compartimos, como creo, la idea de que la Ciencia es cada vez más necesaria para el progreso sostenible de nuestras sociedades. A conseguir este estado de felicidad también ayudaría que las instituciones, de una vez por todas, crearan sistemas estandarizados y compatibles para presentar los proyectos y currículos que deban ser evaluados, y rebajaran la presión burocrática sobre los enjutos cuerpos de los investigadores. En estas situaciones tan estresantes para la autoestima y el bienestar personal, estoy seguro que nos hemos quedado, más de una vez, bastante intrigados tanto sobre cómo es el proceso de valoración como por determinadas expresiones o conceptos de empleo demasiado común entre los científicos de todas las áreas. Me refiero tanto al añejo factor de impacto como al más reciente, por lo menos en las tertulias de café, denominado "índice h", planteado por Jorge Hirsch12,13. Me gustaría dejar claro mi punto de vista sobre estos indicadores bibliométricos, ya que considero que les damos excesivo valor y peso, y más aun aquellos que nos vemos implicados en la evaluación de currículos y proyectos científicos de las diferentes convocatorias públicas y privadas. Debemos considerar también que no se pueden aplicar los mismos criterios para valorar la trayectoria de un científico que los empleados para evaluar la calidad internacional de una publicación científica o de la política científica de un gobierno.

Lo primero que me gustaría resaltar es que hay una unanimidad casi completa en considerar que los valores e índices que se emplean en la mayoría de las comisiones y comités de evaluación de la actividad científica son imperfectos, que es necesario tener muy claro cómo se deben aplicar y que es estrictamente necesario equilibrar las valoraciones en función del área de la ciencia que se evalúa y el número y peso específico de los investigadores que trabajan en esa área. También me gustaría dejar claro que creo que se debería hacer una discriminación positiva de todos aquellos artículos escritos en lenguas científicas minoritarias (y aquí incluyo, que me perdone el lector por mi osadía, al castellano o español) que reciben un número no desdeñable de citaciones bibliográficas. Preguntaba recientemente Richard Gallagher6 a los lectores en un editorial de The Scientist, cómo se sentirían si tuvieran que describir ideas complejas, explicar matices delicados en la interpretación de sus datos y expresar sus pensamientos más creativos en un lenguaje extraño con un vocabulario completamente diferente y una estructura ilógica. La respuesta puede ser tan variada como personas sean preguntadas, pero seguro que podrían confluir todas en tener sentimientos parecidos. Para mí, e imagino que para la mayoría de nosotros, esta es una situación demasiado habitual y nos sucede lo que comenta este autor, que tenemos que realizar habitualmente estas arduas y penosas tareas mientras que la mayoría de nuestros colegas y competidores, que muchas veces actúan como revisores de nuestros artículos originales y guardianes de la pureza de nuestro tema de trabajo, están felizmente escribiendo y exponiendo en su lengua materna sus resultados en congresos y revistas científicas. Por esto y por otras menudencias más, estoy convencido de que es necesario que nuestras agencias de evaluación apliquen un coeficiente de discriminación positiva de los manuscritos escritos en castellano o en inglés en las revistas nacionales (sobre este detalle volveré más adelante).

Es cierto que el inglés es la lingua franca de la ciencia actual, pero lo que no se puede tolerar es que esta lengua sirva de pretexto y permita que los países anglosajones hayan creado un monopolio de la comunicación científica. Algo tan aleatorio como son el lugar o la cultura donde se ha nacido o crecido no debería beneficiar a unos en perjuicio de otros cuando la calidad científica es incuestionable, y las autoridades científicas de un país como el nuestro deberían potenciar la publicación científica de calidad en la lengua oficial del propio país. Aquí nos encontramos con la denominada "paradoja científica iberoamericana", donde los gobiernos autonómicos y nacionales subvencionan las publicaciones locales, pero de manera simultánea llevan a cabo una acción de minusvalorar o desdeñar los artículos que se publican en esas mismas revistas que subvencionan22. Debemos resolver esta paradoja y promover una valoración más positiva de nuestras revistas para conseguir un efecto que ayude a la investigación de nuestras naciones con la publicación de mejores contribuciones científicas. Un apoyo efectivo a las revistas científicas irá unido de forma indisociable con el incremento en la calidad de los trabajos de investigación y esta pueden ser una fuente importante de generación de riqueza para nuestro país4.

Nuestra postura debe ser flexible y adaptativa, con la potenciación y exigencia de que una parte importante de los mejores artículos de nuestros grupos de investigación más punteros se publiquen, bien en castellano o bien en inglés, en nuestras mejores revistas nacionales o supranacionales. La importante labor que están realizando instituciones públicas, como la FECYT10, o privadas, caso de la Fundación Lilly11, merece todos nuestros respetos y felicitaciones, pero es necesario un esfuerzo todavía mucho mayor en esta dirección. Si el dinero y las inversiones provienen de nuestros contribuyentes, los beneficios asociados a las publicaciones deben ser globales, y también deben participar en el reparto nuestros países, ayudando a la creación de mayor riqueza local y potenciando nuestras publicaciones científicas y grupos de investigación para que a su vez generen más riqueza. Ni hay que ser chovinista en exceso, ni beber los aires de cualquier cosa, buena o mala, que venga de fuera. Hay que buscar un equilibrio si no queremos que se desmantelen los recursos y estructuras científicos propios a favor de nadie o de otros países que ya, de por sí, nos llevan una ventaja en lo económico, social y científico de varios lustros4.

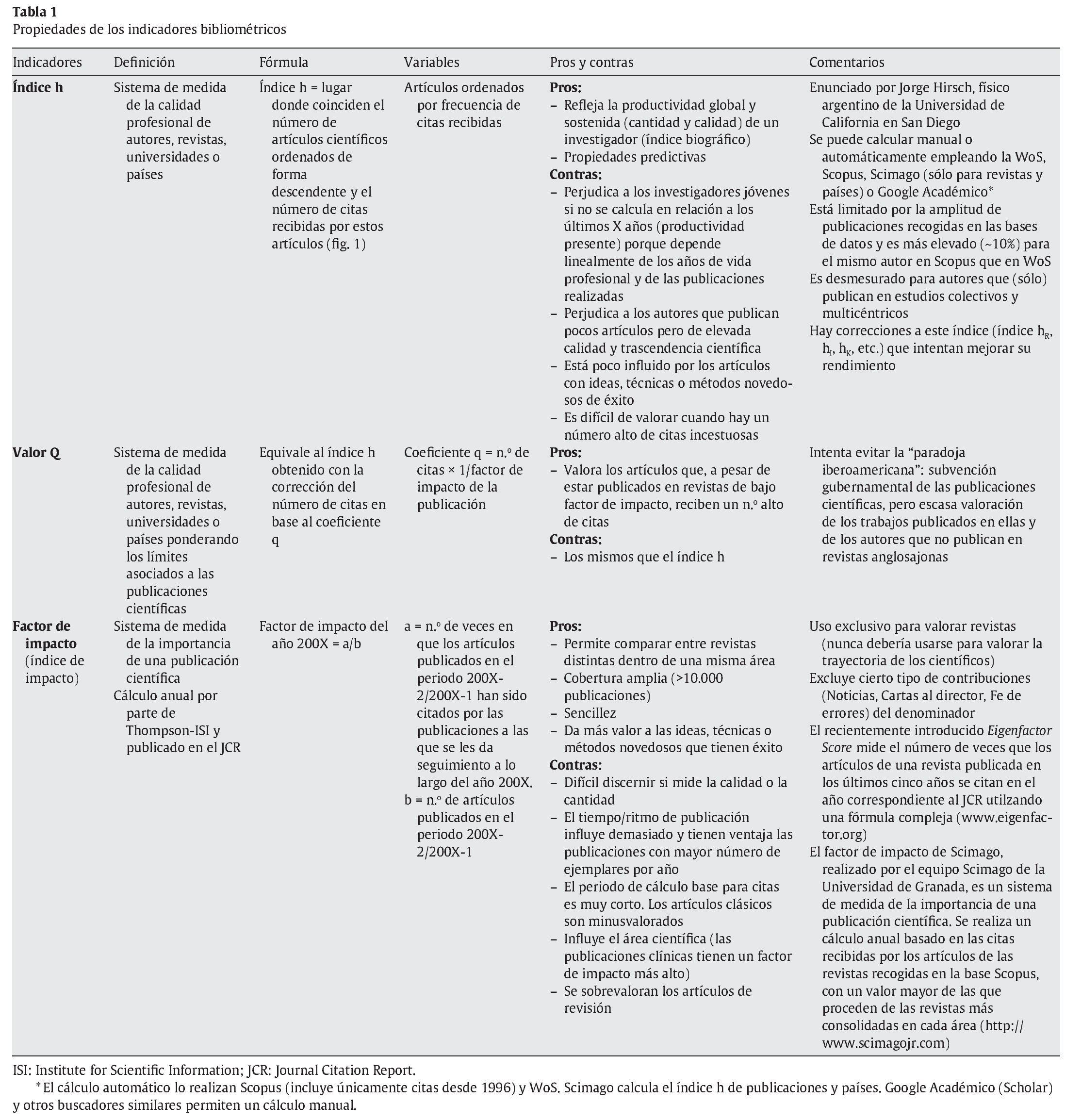

Cuando se valora la vida profesional de un científico se produce otra curiosa paradoja. El valor de sus contribuciones se calcula "a peso" simple (número de artículos publicados) o matizado (en qué tercio del Science Citation Index se encuentran las revistas en las que hemos publicado). La valoración de las contribuciones científicas según su ubicación por áreas científicas en el Journal Citation Report (JCR) no es una cosa del pasado porque, en una encuesta realizada en mayo de 2009 entre investigadores principales de proyectos del Fondo de Investigación Sanitaria de España, se incluía una pregunta sobre las publicaciones y en qué rango de factor de impacto de las revistas científicas incluidas en el JCR se situaba la media de las publicaciones realizadas. Es difícil valorar la calidad de las publicaciones y más aún cuando hay muy poca diferencia entre la finalización de un proyecto y las publicaciones generadas. Aquí utilizar el número de citas recibidas tampoco ofrece demasiada ayuda, porque no ha habido suficiente tiempo real para que la comunidad científica valore y mencione estos artículos. Esta valoración con el factor de impacto de las revistas como base para saber cómo situar al investigador en su campo científico es bastante errónea, porque ni un número alto de publicaciones es igual a calidad, ni que se publique en revistas con un factor de impacto elevado (del primer tercio de cada área) es equivalente a una mayor trascendencia científica. Esto último viene a ser todavía más preocupante cuando hay diferentes estudios que reflejan el mismo resultado: que la mayoría de los artículos publicados en revistas de alto factor de impacto no reciben demasiadas citas en los trabajos de otros investigadores, y que cerca del 50% no reciben ninguna21. En la tabla 1 describo las principales características de los indicadores bibliométricos que podrían ayudar en estas labores de valoración y selección, resaltando que siempre se deben utilizar cuando estén indicados (el factor de impacto no sirve para evaluar a los autores), y que si se quieren realizar comparaciones éstas sólo son adecuadas cuando los investigadores pertenecen a la misma área o campo de la Ciencia3,4,12.

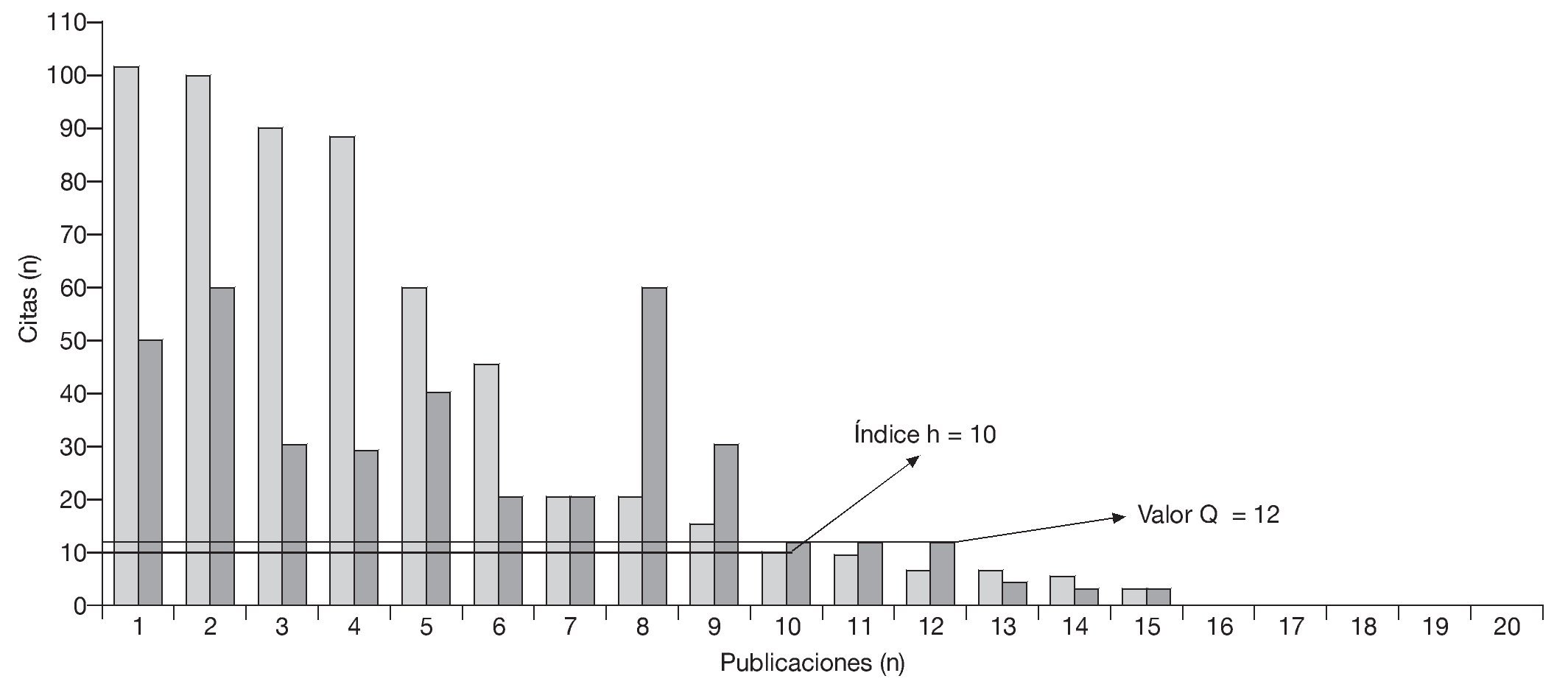

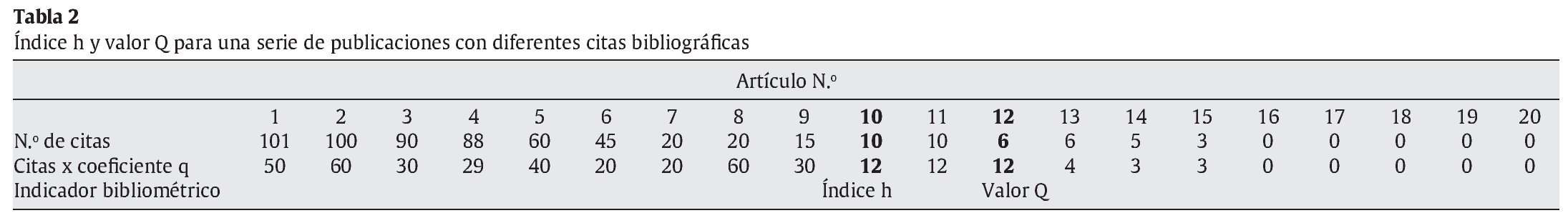

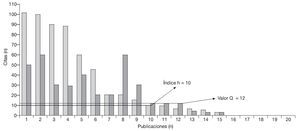

La introducción del índice h ha permitido mejorar la evaluación de los investigadores porque es un índice más estable que realmente valora la importancia de las publicaciones al relacionarlas con las citas obtenidas en cada una de ellas. Aunque la definición de lo que significa el índice es un tanto barroca ("un científico tiene un índice h si el h de sus Np trabajos tiene al menos h citas cada uno y los otros Np-h trabajos no tiene más que h citas cada uno")12,21, su cálculo y su esencia filosófica son sencillos. De hecho, las bases de pago WoS y Scopus permiten el cálculo automático del índice h y otras herramientas gratuitas, como las que aporta Google Académico, que facilitan su cálculo manual. En esencia, si decimos que un autor tiene un índice h de 25 queremos decir que ese autor tiene por lo menos 25 publicaciones que han sido citadas por lo menos 25 veces cada una de ellas. Este índice introduce una ordenación de las publicaciones de cada autor en relación al número de citas obtenidas, y en el valor en el que se cruzan el número de orden y el número de citas se establece el índice h (tabla 2 y fig. 1). Se han realizado bastantes estudios sobre la utilidad real y la aplicada de este índice en diferentes campos del conocimiento científico, y hay numerosos artículos de opinión sobre su valor, incluso predictivo, y cómo aplicarlo7,9,12,13,15,17,21. Se ha resaltado su robustez, su estabilidad, que se incremente su valor y no disminuya a lo largo de la vida profesional, y que sea poco influido por factores que pueden alterar otros indicadores, como la presencia esporádica de determinados autores en estudios multicéntricos que reciben un número elevado de citas7,9,13-15. Un artículo interesante es el del equipo Scimago9, donde el índice h refleja las características y variaciones según el área científica de trabajo de científicos españoles de prestigio como Barbacid, Oro, Rodés, Soria o Zuazua. Basándonos en algunos trabajos, como el de Salgado y Páez en el campo de la Psicología social21, los índices h de los catedráticos y los sexenios obtenidos por éstos no tienen una relación demasiado directa. El número de sexenios está más asociado con la antigüedad como catedrático en la mayoría de los casos que con la calidad de la producción científica. Tal vez este hecho sea un matiz o característica españoles, si tenemos en cuenta la historia reciente de nuestro país, y no sea extrapolable a otros países, o por lo menos no a los anglosajones y a la mayoría de los países del centro y norte de Europa, donde hay una asociación más estrecha entre cargos, puestos y el índice h13.

Figura 1. Cálculo del índice h y del valor Q de un supuesto investigador.

Hablar del índice h me hace recordar las animadas discusiones mantenidas durante muchos años con compañeros y amigos y, en especial, con José Schneider Fontán y José Pontón San Emeterio, sobre si se debe valorar más un artículo científicamente consistente y avalado por numerosas citas de otros autores, que ha sido publicado en una revista con pocos medios y menor repercusión internacional a priori (es decir, con un bajo factor de impacto). Mi opinión siempre ha sido que sí, que se debe valorar más porque se compite en desventaja desde el primer momento por múltiples razones históricas y estructurales de nuestro país (acordémonos del largo desierto científico que supuso nuestro reciente periodo histórico totalitario). Por eso, la repercusión obtenida por un artículo con un número de citas alto en una revista con un bajo factor de impacto debería valorarse más que un mismo número de citas obtenidas por un artículo publicado en una revista extranjera (sobre todo anglosajona) con mayor factor de impacto. Los autores que publican en revistas con factores de impacto menores de 2 sufren una penalización evidente y en estos parámetros se encuentran la mayoría de las revistas de nuestros países que, además, experimentan la anteriormente denominada paradoja iberoamericana y el ouraboros de la poca visibilidad internacional22.

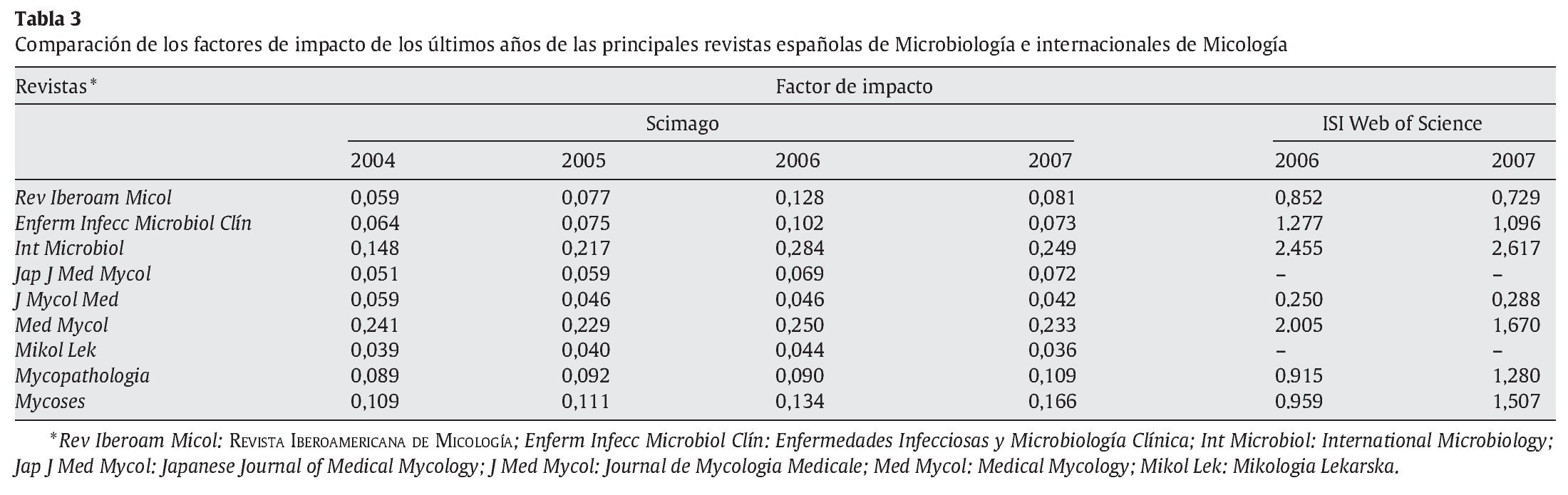

Creo que hay razones científicas suficientes para plantear que es necesaria la utilización de un coeficiente corrector, que me he permitido denominar "q", para obtener un relativo equilibrio que ampare a nuestras revistas en la escasamente democrática biota de las revistas científicas, y la utilización de un "valor Q" cuando lo que se intenta es valorar la biografía científica de un investigador español o iberoamericano. Este valor Q corregiría al índice h con un coeficiente q (coeficiente q = 1/factor de impacto de la revista en que aparece el artículo publicado) (tabla 2 y fig. 1). Habría que introducir una serie de límites en su aplicación, incluyendo los artículos con un número mínimo de citas (¿5?) publicados en las revistas que aparecen en bases bibliográficas consideradas de forma unánime como prestigiosas3-5,16,18. Probablemente, las tres consideradas como más influyentes y con criterios más claros de selección son PubMed/Medline, Thomson-ISI Web of Science/Science Citation Index (WoS) y Scopus, que recogen una pequeña parte de las más de 200.000 publicaciones existentes. La primera es la única de carácter público (National Institutes of Health, EE.UU.) y no hace valoraciones de las citas recibidas por las publicaciones, ni calcula el índice h de los autores. Scopus recoge la información de un número elevado de revistas ya que incluye alrededor de 17.000 publicaciones. De forma anual desde la década de 1970, Thomson-ISI publica el JCR, repertorio que recoge información estadística de alrededor de 10.000 de las revistas más importantes de las áreas científico-tecnológicas y de las ciencias sociales. El factor de impacto es la estrella mediática del JCR, ya que realiza una clasificación científica de las revistas. Este factor está influido por muchísimos y muy diferentes condicionantes, y su correlación es fuerte y significativa con el número (medio) de autores por artículo y el factor de impacto medio de una área determinada de la ciencia. De aquí que sea fundamental que únicamente se comparen factores de impacto de revistas dentro de la misma área científica3. Por ejemplo, los valores del factor de impacto oficioso de la REVISTA IBEROAMERICA DE MICOLOGÍA han oscilado entre 0,606 en 2001 [2] y 0,852, en 2007, y 0,729, en 200819, y sitúan a nuestra Revista en una posición humilde cuando se la compara con otras revistas de las áreas de la Microbiología o la Micología (tabla 3)5. Las variaciones del factor de impacto son mayores en las revistas pequeñas, como la nuestra, y hay que ser muy precavido al sacar conclusiones: una variación del factor de impacto debe ser mayor del 22% para considerarse significativa e indicar un ascenso o disminución real de la importancia de esa revista en un área científica concreta.

El factor de impacto se basa completamente en las citas bibliográficas, y aquí entramos en otra parte importante para el debate, la que se refiere a si tienen todas las citas el mismo valor. Seleccionar citas complica las cosas pero debemos valorar sobre todo aquellas que proceden de otros autores. Es decir, deberíamos eliminar las autocitas (citas "incestuosas") o crear un límite lógico de éstas. La compulsiva autocitación que padecemos muchos es difícil de explicar (¿ego demasiado grande?). Sin embargo, hay citas incestuosas que podrían ser válidas. ¿Cuáles? La respuesta es complicada, pero podríamos considerar que son aceptables todas aquellas que se refieren a un método descrito por el mismo autor si el método es original o muestra una modificación importante de un método descrito previamente por otros autores. El caso opuesto estaría en la discusión de los resultados actuales con los denominados resultados históricos: muchos de estos artículos son simplemente versiones anuales actualizadas de un primer artículo, y la bibliografía está llena de numerosas autocitas.

Otro problema importante son las citas procedentes de las denominadas "mafias curriculares" o los denominados "parásitos científicos"1,23. Aunque deseo pensar que estas mafias curriculares no han enraizado dentro de la Micología iberoamericana, es un hecho que se comportan como auténticas máquinas de publicar artículos de autoría múltiple, con el agravante de que, a su vez, tienden a autocitarse y citar los artículos del resto de los componentes de la fratría. En base a este fenómeno paracientífico se han propuestos otros índices y factores que deberían ser tomados en cuenta, como el factor k ("por la cara"), para depurar mejor la labor evaluadora1,14,15. Un problema casi insoluble asociado a las citas bibliográficas, porque cuando hablamos de citas recibidas presuponemos que las citas son elogiosas o, por lo menos, neutras, es la crítica a las conclusiones u opiniones expresadas por el autor. ¿Cómo se valoran estas citas críticas? Hasta ahora son parte del sumatorio total de citas recibidas y no se hacen distinciones con el resto de las citas.

Además aparecen los problemas relacionados con las pérdidas o equivocaciones con las citas recibidas por un autor o artículo. Éstos van desde el equívoco con la revista referenciada a la hora de abreviarla, hasta los más serios problemas con los apellidos y nombres compuestos de los autores. Este problema es mayor en los países en los que empleamos los apellidos paterno y materno. En mi caso concreto, y a pesar de no tener un apellido paterno demasiado frecuente, mis publicaciones aparecen recogidas en las diferentes bases de datos (WoS, PubMed-Medline o Scopus) de varias formas diferentes (Quindós G, Quindós Guillermo, Quindós-Andrés G, Quindós-Andrés Guillermo, Andrés GQ y Andrés Guillermo Quindós), lo que dificulta las búsquedas bibliográficas y el cálculo de índices y valores bibliométricos. Por eso es conveniente resaltar la gran importancia de emplear siempre el mismo nombre en las autorías de los artículos, como se ha propuesto desde la FECYT10, y su repercusión ha sido evaluada en algunos trabajos19. En el caso de nuestros nombres, si usamos ambos apellidos, lo más razonable es unir con un guión el apellido paterno con el materno porque las bases bibliográficas aplican las reglas de nombres anglosajones. También puede ocurrir lo contrario, y es que aparezcan en estas bases bibliográficas más artículos de los que realmente nos corresponden. La base bibliográfica Scopus posee herramientas que facilitan la búsqueda correcta de las publicaciones de cada autor, y la WoS permite un ajuste fino manual de los datos encontrados. Es, por lo tanto, recomendable que el autor que envía el trabajo para que sea publicado se fije bien en cómo están escritos los nombres de los autores y, en caso de duda, se lo pregunte a éstos para no encontrarse en situaciones desagradables indeseadas.

Me gustaría concluir recordando que es muy importante llevar a cabo una labor desmitificadora sobre los indicadores bibliométricos, y que el factor de impacto sólo sirve para valorar y comparar revistas y no para valorar currículos de investigadores. Si tenemos que realizar la difícil labor de comparar los currículos de dos o más investigadores tenemos que utilizar el índice h o el hipotético valor Q. Este último permitiría ponderar y discriminar positivamente la importante labor realizada por nuestros investigadores, que se deben enfrentar al doble reto científico y lingüístico para sobrevivir a la cruel regla del "publish or perish".

Conflicto de intereses

El autor declara no tener ningún conflicto de intereses.

Financiación

Los trabajos de investigación del autor están financiados en el momento actual por los proyectos GIC07 123-IT-222-07 (Departamento de Educación, Universidades e Investigación, Gobierno Vasco), S-PE-08UN35 (Saiotek 2008, Departamento de Industria, Comercio y Turismo, Gobierno Vasco) y PI061895/2006 (Fondo de Investigación Sanitaria del Ministerio de Sanidad y Consumo de España).

Correo electrónico:guillermo.quindos@ehu.es

INFORMACIÓN DEL ARTÍCULO

Historia del artículo:

Recibido el 9 de junio de 2009

Aceptado el 9 de junio de 2009