Los indicadores bibliométricos surgen para cuantificar la producción científica e intentar evaluar su impacto en la comunidad. De forma general, se pueden dividir en indicadores bibliométricos de autores (individuales y de colaboración) y de revista. Los más extendidos dentro del primer grupo son los que miden la producción individual del autor, como el índice de Crown y el índice h y derivados (índice e, índice h5 y el absoluto o Ab-index, entre otros). Los indicadores bibliométricos creados para intentar valorar la calidad de la revista son los asociados al Journal Citation Reports (como factor de impacto, el impacto ajustado a un campo de investigación, eigenfactor y la influencia por artículo) o asociados a Scopus [Scimago Journal Rank (SJR), el impacto por artículo normalizado por la fuente de cita (SNIP) y CiteScore). El objetivo de este artículo es presentar los principales indicadores bibliométricos, explicar cómo se calculan y discutir sus ventajas y limitaciones.

Bibliometric indicators have been devised to quantify scientific production and to try to evaluate its impact in the community. In general, bibliometric indicators can be classified according to whether the unit of analysis is the author (individual or group) or journal. The most widely used indicators for authors are those that measure an individual author's production, such as the Crown index or the h-index and its derivatives (e-index, h5-index, and the absolute or Ab-index, among others). The bibliometric indicators devised to try to evaluate journal quality are associated with Journal Citation Reports (e.g., impact factor, field-weighted citation impact, Eigenfactor, and article influence) or with Scopus (Scimago Journal Rank (SJR), source normalized impact per paper (SNIP), and CiteScore). This article describes the main bibliometric indicators, explains how they are calculated, and discusses their advantages and limitations.

La bibliometría fue definida por Alan Pritchard en 1969 como la aplicación de métodos matemáticos y estadísticos a las publicaciones científicas, y a los autores que la producen, para evaluar y clasificar la actividad científica1; más tarde, Eugene Garfield la describió como “la cuantificación de la información bibliográfica susceptible de ser analizada”2. Gracias a este análisis es posible estudiar el tamaño, crecimiento y distribución de los documentos científicos y analizar la estructura y dinámica de los grupos que producen y consumen dichos documentos3,4.

Para expresar cuantitativamente las características bibliográficas de un documento o conjunto de documentos se utilizan los indicadores bibliométricos (IB), que son datos numéricos que representan diferentes rasgos de la actividad científica vinculados tanto a la producción como al consumo de información5. Los IB son calculados de una forma objetiva y reproducible6 a partir de un gran volumen de datos disponibles en las bases de datos de referencias internacionales7.

Las tres bases de datos principales que ofrecen análisis bibliométricos y búsquedas de citas son Scopus, Web of Science y Google Scholar8. Cada una tiene sus propias métricas además de algunas estándar como el índice h.

Scopus fue creada en 2004 por Elsevier9. Tiene indexadas más de 20000 revistas de ciencia, tecnología, medicina, ciencias sociales, arte y humanidades. Además, incluye libros y actas de congresos. Sus métricas propias son SCImago Journal Rank (SJR) y Source Normalized Impact by Paper (SNIP).

La Web of Science se incluye en la plataforma Web of Knowledge (WOK) de Clarivate Analytics10. Indexa unas 11000 revistas que son seleccionadas dependiendo del número de citas que reciben. Su métrica más relevante es el conocido factor de impacto.

Google Académico11 es un buscador gratuito que indexa los textos completos de muchos artículos junto con un índice de citas que ayuda a conocer el impacto de cada uno12. Incluye también otros formatos de publicaciones como libros, tesis, informes técnicos, patentes y libros de resúmenes de congresos científicos.

Otras bases de datos de revistas (aunque no incorporan índices métricos ni realizan informes de citas) son MEDlars on LINE (MEDLINE)13 (que incluye PUBlic MEDline (PubMed) Central con más de 25000 revistas indexadas y Excerpta Medica dataBASE (EMBASE)14 que incluye en torno a 9000 revistas.

Asumiendo que el resultado de una investigación es conocimiento nuevo que se difunde a través de las publicaciones, los IB son válidos para evaluar la producción científica y su impacto en la comunidad15. Por ello, pueden ser utilizados para planificar y racionalizar los recursos económicos destinados a la investigación16.

El objetivo de este artículo es presentar los IB fundamentales, explicando cómo se calculan y cuáles son sus ventajas y limitaciones

Tipos de indicadores bibliométricosUna de las clasificaciones generales más extendidas divide los IB en cualitativos (relacionados con la calidad de una revista, como el factor de impacto) y cuantitativos (se pueden medir numéricamente, como el índice h)3. No obstante, para obtener un índice cualitativo se deben emplear criterios cuantitativos, ya que se calcula “contando” el número de citas. Para evitar confusiones sobre cómo se calculan y qué miden exactamente, en este artículo seguiremos una clasificación que divide los IB dependiendo de si se aplican a los autores/grupos de investigación o revistas.

Indicadores de autores o gruposExiste un interés creciente en evaluar objetivamente cuál es la contribución efectiva de un investigador o de un grupo de investigación y, con ello, cuál es realmente su impacto científico para establecer las diferencias. Así, se han establecido 6 categorías: indicadores de actividad científica, indicadores de producción científica e impacto, indicadores de colaboración, indicadores de diseminación, indicadores de producción e indicadores de impacto en los servicios de salud17. Los más extendidos son los de producción científica y los de colaboración.

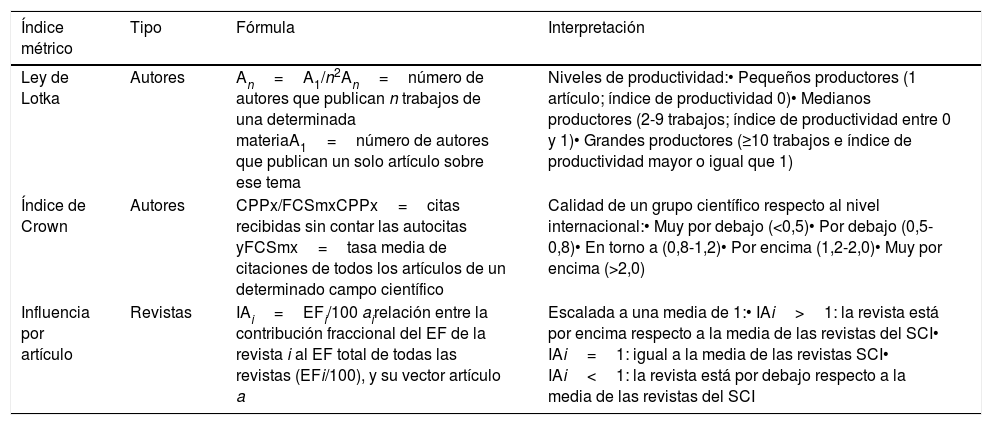

Indicadores de producción científica1. Número total de publicaciones. Puede aplicarse tanto a autores como a grupos y considera simplemente su número de artículos. El índice está regido por la ley de Lotka o de productividad científica, que establece que el número de autores que publican n trabajos sobre una materia es inversamente proporcional al cuadrado de esos n artículos publicados18,19 (tabla 1). Una limitación es que no tiene en cuenta el número de autores, dónde se indexan las revistas en las que se ha publicado, las citas que haya recibido o el tipo de artículo (es lo mismo escribir un artículo original que una carta científica), por lo que es una medida de productividad sesgada y no pondera el impacto real que tiene un trabajo científico.

Fórmulas e interpretación de algunos índices métricos

| Índice métrico | Tipo | Fórmula | Interpretación |

|---|---|---|---|

| Ley de Lotka | Autores | An=A1/n2An=número de autores que publican n trabajos de una determinada materiaA1=número de autores que publican un solo artículo sobre ese tema | Niveles de productividad:• Pequeños productores (1 artículo; índice de productividad 0)• Medianos productores (2-9 trabajos; índice de productividad entre 0 y 1)• Grandes productores (≥10 trabajos e índice de productividad mayor o igual que 1) |

| Índice de Crown | Autores | CPPx/FCSmxCPPx=citas recibidas sin contar las autocitas yFCSmx=tasa media de citaciones de todos los artículos de un determinado campo científico | Calidad de un grupo científico respecto al nivel internacional:• Muy por debajo (<0,5)• Por debajo (0,5-0,8)• En torno a (0,8-1,2)• Por encima (1,2-2,0)• Muy por encima (>2,0) |

| Influencia por artículo | Revistas | IAi=EFi/100 airelación entre la contribución fraccional del EF de la revista i al EF total de todas las revistas (EFi/100), y su vector artículo a | Escalada a una media de 1:• IAi>1: la revista está por encima respecto a la media de las revistas del SCI• IAi=1: igual a la media de las revistas SCI• IAi<1: la revista está por debajo respecto a la media de las revistas del SCI |

2. Índice Crown. Este índice, también conocido como citas normalizadas por área de interés (field normalized citation score)20, surge para atender la variabilidad que existe entre el número de citas según el área científica y los años de publicación (un artículo antiguo va a tener más citas que uno recién publicado)21,22.

Se calcula dividiendo la media de citas recibidas por los artículos de un investigador o grupo de investigación (excluyendo las autocitas) en un área de interés durante un periodo, por el promedio de citas recibidas por todos los artículos publicados en revistas científicas de dicha área en ese espacio de tiempo20–23 (tabla 1).

Su principal ventaja es que puede comparar el impacto de la producción en investigadores de diferentes disciplinas24. Sin embargo, un problema que lo limita es la inadecuada clasificación de un artículo en un campo, lo que ocurre con mucha frecuencia en radiología: un artículo radiológico publicado en una revista general no será asignado al campo de la imagen y no contribuirá al cálculo del índice en ese campo25. También se afecta por el tamaño del grupo de investigación, ya que cuantos más investigadores lo compongan, mayor será el número de publicaciones del grupo. Por ello, es recomendable aplicarlo para comparar grupos de investigación con un número similar de integrantes20.

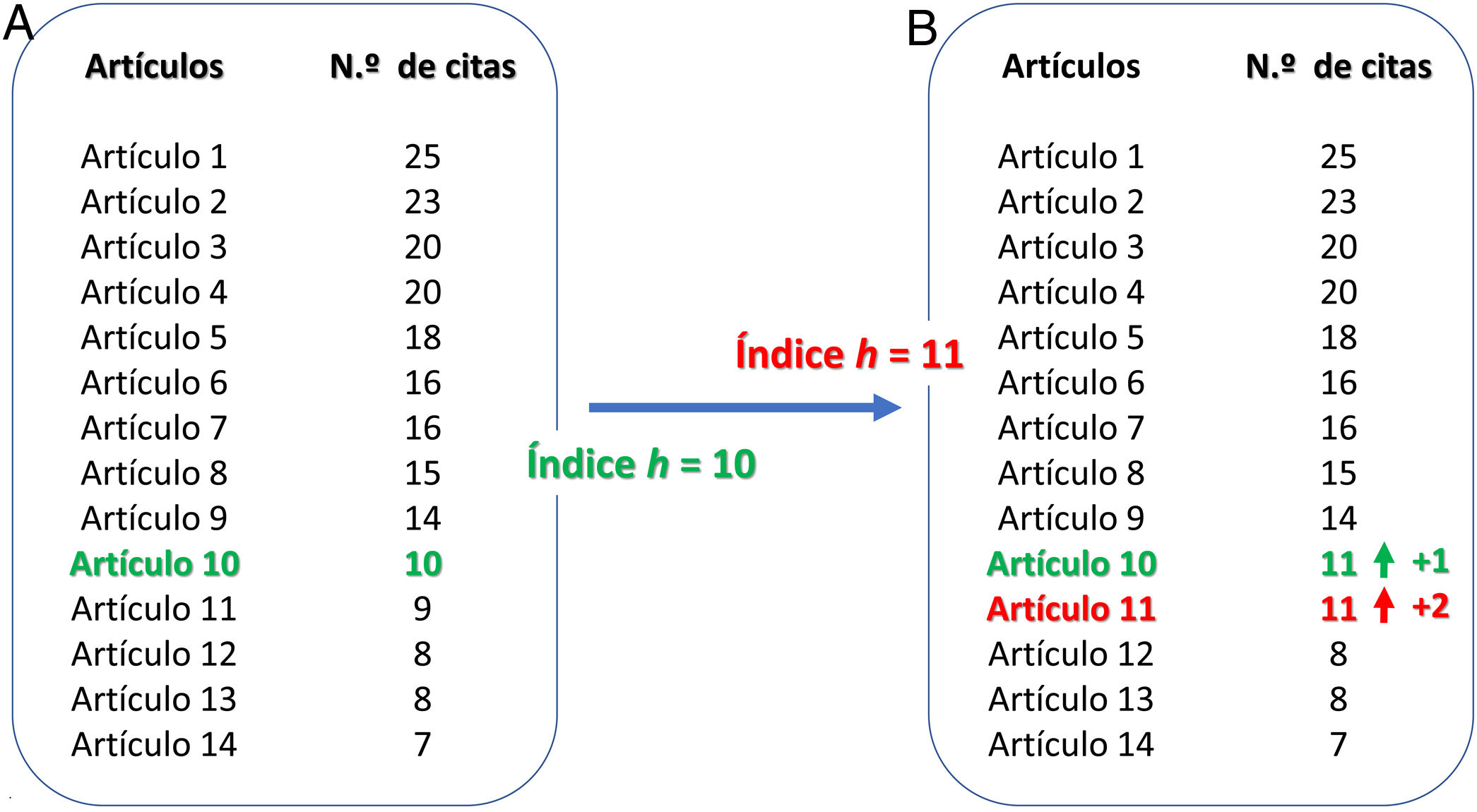

3. Índicehy sus derivados. El índice h, propuesto por Hirsh en 2005, es uno de los indicadores de productividad de autores más conocido, pero se puede utilizar también para analizar la producción de departamentos o grupos de investigación, y comparar el índice h medio de todas las universidades o facultades de un país con campos de investigación similares26. Se define como el número [h] de artículos publicados por el autor de entre su número total [N] de artículos publicados, con al menos [h] citas cada uno, mientras que el resto [N-h] de sus artículos publicados han sido citados menos de [h] veces cada uno26 (fig. 1). Este hecho explica por qué el aumento del índice h es cada vez más lento en la vida científica de un autor y por qué no aporta información sobre las citas de los artículos que quedan por encima del índice y que pueden tener un gran impacto27. Por ello, la información aportada por el índice h se puede complementar con el índice e, que considera las citas extras de los artículos que contabilizan para el índice h; es decir, si un autor tiene un índice h de 5, el índice e se calcula con las citas que exceden a 5 de los 5 artículos que cuentan para el índice h, lo que permite valorar el ritmo de citación de esos artículos28. Se ha demostrado que hay una relación de crecimiento exponencial entre el índice h y el grado académico29.

Índice h. La figura representa cómo el índice h de un autor sube de 10 a 11. En el momento A, el autor tiene un índice h de 10. Nótese cómo la coincidencia de “n” artículos que tienen “n” o más citas es el 10. El autor ha publicado 14 artículos de los cuales 10 han tenido al menos 10 citas, mientras que los cuatro restantes se han citado en menos de 10 ocasiones. En un momento posterior B, el artículo 10ha tenido una cita más. Si eso fuera todo, se seguiría cumpliendo que solo 10 de sus artículos tienen 10 o más citas, y el índice h seguiría siendo el mismo. Pero en ese tiempo, el artículo 11 también ha sido citado dos veces más y ha alcanzado 11 citas. Quiere decir que el autor tiene ahora n=11 artículos con 11 citas o más y su índice h ha pasado a ser de 11. Nótese ahora que el índice h seguirá siendo el mismo independientemente de las citas que esos 11 artículos sigan recibiendo. Para que suba a 12 hará falta que cualquiera de esos tres artículos restantes (12, 13 o 14) sean citados hasta que uno de ellos alcance las 12 citas. Finalmente, si suponemos que el autor no publicará nunca más artículos que esos 14, se deducirá que su índice h máximo no será superior jamás a 14.

El índice h tiene dos limitaciones principales. Por un lado, su temporalidad, ya que no da una medida real de la producción actual de un autor ni información dinámica sobre su productividad; un autor puede tener un índice h alto a expensas de artículos antiguos27. Esta limitación puede afrontarse con variantes del índice h como:

- •

Factor de impacto de autor o índice h5: se restringe a las citas de los artículos publicados en los últimos 5 años30.

- •

Índice m: divide el índice h por el número de años desde que el autor publicó su primer artículo, lo que permite comparar investigadores en diferentes momentos de su carrera31.

- •

Índice contemporáneo (Hc): multiplica las citas de un artículo por cuatro y divide el producto por el número de los años desde que el artículo fue publicado27. Con ello se da más valor a las citaciones de los artículos más recientes sobre los más antiguos, lo que permite diferenciar dos investigadores con el mismo índice h, pero con carreras científicas de diferente duración.

Su segunda limitación es que cuanto mayor sea el número de autores, más difícil es cuantificar su contribución real en cada artículo y el índice h los puntúa a todos por igual. Esta limitación puede afrontarse con el índice h ponderado (w), que da más valor al primer autor y al de correspondencia que al resto de los coautores, a quienes puntúa de manera decreciente27. Además, el índice h no tiene en cuenta la colaboración entre autores de diferentes grupos. Es decir, un autor puede estar en múltiples grupos y “acumular” índice h sin tener un lugar relevante en la lista de autores. El índice de colaboración o índice A tiene en cuenta este hecho asignando valores relativos a los coautores de un artículo, dividiendo dentro de un ranking de grupos32,33. Más recientemente se ha descrito un índice absoluto (Ab-index) que refleja la contribución científica individual en su campo de investigación, ajustada por grupos de edad y número de autores: cuando el número de autores aumenta, disminuye la puntuación de cada uno, siendo mayor la pérdida que sufre el primer autor con respecto al resto34.

El índice h puede variar dependiendo de la base de datos consultada: por ejemplo, el índice h de un autor en Scopus (que recoge datos desde 1996) puede ser menor que el que tiene en Google Académico que lo calcula abarcando un período de tiempo mayor27.

Indicadores de colaboraciónLa colaboración entre autores se considera la forma más frecuente de interacción entre científicos35 y culmina normalmente con la publicación conjunta de resultados36.

Los índices de colaboración evalúan cómo es esta interacción entre investigadores y se pueden calcular por autor, institución y país de afiliación.

La colaboración entre investigadores puede adoptar diferentes formas, dependiendo de quiénes intervengan en esa colaboración y su grado de implicación37. Por ejemplo, un investigador novel puede realizar un trabajo conjunto con otro más consolidado (cuya contribución puede ser únicamente supervisando el trabajo; también puede establecerse colaboración entre colegas con un grado académico similar y entre instituciones u organizaciones, como en estudios multicéntricos nacionales o internacionales.

Dentro de los índices de colaboración, los más extendidos son la tasa de colaboración (o índice firmas/trabajo), que mide el número de publicaciones con autoría múltiple, y los patrones de colaboración, que permiten identificar aquellos individuos o instituciones que más publican de forma conjunta.

El análisis de los índices de colaboración también puede detectar “autorías honorarias” (incluir como coautores a directores o jefes de departamento por su posición y sin realizar el trabajo) o la “autoría de agradecimiento” (incluir como autor personal de apoyo técnico, como estadísticos)35.

Indicadores de revistasDe forma general, puede decirse que una revista científica tiene rigor científico si cumple una serie de aspectos formales como una periodicidad de publicación, definición del comité editorial y publicación de las instrucciones a los autores y revisores. También es importante que explique si el proceso de revisión de artículos sigue una revisión por pares o Peer Review (al menos dos expertos en la materia). Aunque tradicionalmente la evaluación a ciegas se consideraba un criterio de calidad, actualmente es un tema controvertido, ya que hay revistas que no anonimizan a los revisores y otras tampoco a los autores, que sabrán quién les revisa38,39. Además del rigor científico, se necesita evaluar de alguna forma la influencia que tiene una revista determinada dentro de la comunidad científica, para lo cual se utilizan los IB.

Factor de impactoEn 1955, Garfield funda el Institute for Scientific Information (ISI) en el que idea un índice para medir la calidad de las revistas científicas7. Este indicador fue denominado por primera vez como factor de impacto (FI) en 1963. El ISI desarrolló en 1964 el Science Citation Index (SCI), que es una de las bases de datos del instituto, pero relevante en el ámbito de la medicina, ya que incluye las revistas de ciencia y tecnología, rigurosamente seleccionadas. Basándose en el SCI, el ISI empezó a calcular, primero esporádicamente, el IF de cada una de las revistas incluidas, y, a partir de 1975, anualmente, adquiriendo relevancia al publicar los resultados en el Journal of Citation Report (JCR). La información científica indexada en el SCI está disponible online en la Web of Knowledge (WOK)10 y, dentro de ella, en la Web of Science (WOS).

ISI fue vendido a la Thomson Scientific & Healthcare Corporation en 1992 (Thomson ISI), y esta a la Onex Corporation y Baring Private Equity Asia en 2018, en la que hoy es Clarivate Analytics40.

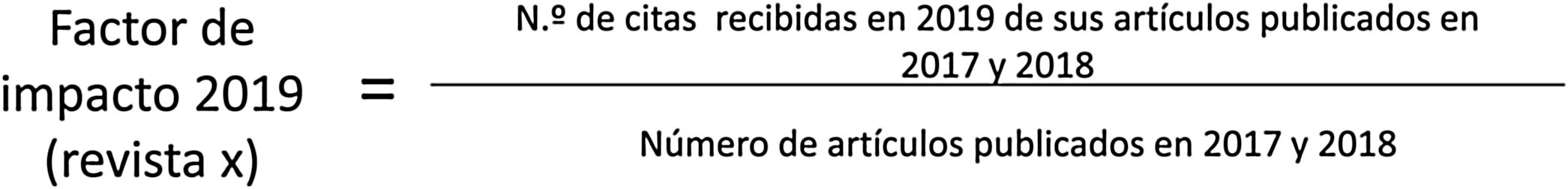

Para calcular el FI de una revista en un año concreto se tienen en cuenta las citas y los artículos publicados en las revistas del ISI (Clarivate) durante los 2 años previos27 (fig. 2).

Factor de impacto (FI). Para calcular el FI 2019 de una revista indexada en el Science Citation Index (SCI) se debe dividir el número de citas que han recibido durante 2019 los artículos publicados en esta revista en 2017 y 2018, entre el número de artículos publicados en esa revista durante esos dos mismos años. Solo computan las citas que provienen de revistas incluidas en el SCI para revistas del SCI, por lo que solo ellas tienen un FI oficial, que es el que publica el Journal of Citation Report (JCR).

Las revistas indexadas en el SCI son clasificadas en diferentes disciplinas, mostrando así las revistas que se citan con mayor frecuencia en un campo. En concreto, las revistas radiológicas se agrupan dentro de la categoría “Radiology, Nuclear Medicine, Medical Imaging”. Dentro de cada especialidad, las revistas se distribuyen en cuartiles (Q1, Q2, Q3 y Q4) atendiendo a su FI, lo que sirve para establecer la importancia científica de cada una en su campo41.

Al tratarse del primer índice cuantitativo y objetivo de una revista, el FI es el índice métrico más aceptado y extendido dentro de la comunidad científica4.

El FI tiene en cuenta las autocitas dentro de una revista, si bien Clarivate no valora las autocitas del autor desde diferentes revistas.

El FI tiene varias limitaciones. Por un lado, evalúa y clasifica revistas, no los artículos que publican ni a sus autores42. Un autor puede publicar en revistas con FI sin obtener después ninguna cita. Por otro lado, dentro de la misma revista no todos los artículos computan para el cálculo del FI sin que haya ningún criterio definido para ello43.

También tiene un sesgo de accesibilidad relacionado con el idioma de publicación. Un artículo escrito en español tiene menos difusión y, por tanto, una probabilidad menor de ser citado que uno publicado en inglés6.

La temporalidad también es otro aspecto que limita la aplicación del FI, ya que se circunscribe a una ventana de 2 años. Por último, el FI no implica siempre más citas porque solo computan en su cálculo las citas procedentes de revistas incluidas en el SCI: una única cita a un artículo proveniente de una revista incluida en el SCI tiene efecto en su FI, mientras que muchas citas a otro artículo, pero desde revistas no incluidas en el SCI, no43. Esto constituye un problema para revistas que, con calidad científica pero un ámbito reducido, solicitan ser incluidas en el SCI, puesto que el criterio fundamental del ISI para indexar una nueva revista es el número de citas que provienen de sus revistas44.

Para intentar paliar estas limitaciones, en 2015 el ISI creó una nueva base de datos en la WOS: el Emerging Sources Citation Index (ESCI)45, que incluye las revistas que tiene en proceso de evaluación para entrar a formar parte de la WOS. Al incorporar todas las publicaciones que se encuentran en evaluación, les da visibilidad y fomenta una mayor claridad en el proceso de selección.

Otros índices incluidos en el JCR1. Impacto ajustado a un campo de investigación (“Field normalized citation score” “Journal-to-field impact score”). Una de las limitaciones que hemos visto en el FI es que no permite comparar revistas dentro de la misma disciplina, ya que hay materias con menor difusión a las que es complicado obtener factor de impacto. Por ello, surgió el Field Normalized Citation Index (FNCI) que fue propuesto por un centro de estudios científicos y tecnológicos de la Universidad de Leiden (Países Bajos) para comparar la producción científica en distintos campos de investigación46. Mide la media de artículos citados en una revista específica y compara este número con el de otras revistas del mismo campo de investigación23.

2.Eigenfactor (EF) y la influencia por artículo (Article Influence Score, AIS). Estos índices pretenden valorar no solo el número de citas, sino la importancia relativa de una publicación dependiendo del tipo de citas que recibe. El EF47, más que el FI, mide la influencia de la revista en la comunidad científica, ya que tiene en cuenta la calidad de la revista desde la que proviene la cita48. Como en el FI, en su cálculo influye tanto el tamaño de una publicación (es decir, el número de artículos que la revista publica anualmente) como el tiempo, ya que incluye únicamente los artículos publicados en los últimos 5 años.

El eigenfactor mide la influencia de la revista, pero no la influencia por artículo como hace el FI. El tamaño de la revista no es un indicador del impacto de sus artículos (WOS). Para ello, el índice bibliométrico es la influencia por artículo (IA), que mide la influencia media de los artículos que se publican en una revista i concreta (tabla 1).

Un valor IAi de 1 significa que la influencia por artículo es igual a la media de las revistas SCI, mientras que valores superiores o inferiores a 1 determinarían cuánto por encima o por debajo de la media está la IA de una revista respecto a la media de las revistas SCI44.

Por ejemplo, en 2012, el AIS para Radiographics fue 1.087, lo que sugiere que los artículos de Radiographics tienen mayor influencia que el promedio de artículos en la literatura científica.

Basados en la base de Scopus1.Scimago Journal Rank. El SJR fue desarrollado por SCImago Research Group de la Universidad de Extremadura (España)49. Al igual que el eigenfactor, el SJR utiliza un algoritmo para dar peso a las citas de acuerdo con la influencia de la revista de la que provienen49. Se calcula a partir de las revistas de Scopus y, a diferencia del EF, la ventana de citas se restringe a los 3 años previos al año para el que se calcula el SJR. Las autocitas no se eliminan, aunque para disminuir su influencia métrica no pueden superar para el cálculo el 33% de todas las citas que la revista recibe50.

En 2012 se introdujo una variante (SJR2) que mide la relación entre citas y revistas citadas, para determinar la relación temática de las revistas, de manera que si te citan las de la misma materia tienen mayor peso. Además, el SJR2 divide el prestigio ganado por una revista por el número de documentos citables. Cuanto más citen una revista determinada revistas relacionadas, más importancia gana la revista en su respectiva disciplina51.

2. Impacto por artículo, normalizado por la fuente de la cita (Source-normalized impact per paper, SNIP). Al igual que el SJR2, este índice, creado en la Universidad de Leiden por H.F. Moed, da un mayor peso a las citas del mismo campo científico52. El SNIP utiliza como documentos útiles para el cálculo los “artículos”, “resúmenes de congresos” y “revisiones” de la base Scopus, y tiene en cuenta: a) la frecuencia con la que los autores citan otros artículos, representada por el número de referencias de sus artículos (las referencias por artículo pueden ser muy diferentes de un campo a otro, y a mayor número de referencias, mayor posibilidad de ser citada); b) la velocidad con que madura el impacto de la citación o número de citas recibidas en un año por los artículos publicados en una revista en la ventana de citación (para el SNIP es de 3 años para no desfavorecer a aquellas disciplinas con maduración lenta), y c) cómo la base de revistas utilizada abarca el campo temático, que en el caso de Scopus es del 80%52,53. Este índice puede utilizarse para comparar revistas de diferentes disciplinas. Un ejemplo de cómo se interpreta este índice es que una cita de un artículo con 200 referencias contará menos que la cita de un artículo con 20 referencias.

3. CiteScore. Pesa a su utilidad potencial como indicadores ponderados, SNIP y SJR se basan en algoritmos complejos que los hace poco transparentes y difíciles de reproducir. Para complementarlos, fue necesario desarrollar en la base de Scopus nuevas métricas que se caracterizasen por la transparencia, una cobertura muy amplia, la frecuencia y la estabilidad54. Con esos fundamentos se desarrollaron las métricas CiteScore. La ventana de citas es de 3 años, como en todas las de Scopus, puesto que este es un tiempo adecuado para incluir la vida media de los artículos en la mayoría de las disciplinas, mientras siguen siendo recientes54,55. Por otro lado, y a diferencia del resto de métricas, incluye todos los artículos publicados (excepto en prensa), independientemente de sus características, en vez de usar categorías no transparentes para decidir cuál entra y cuál no en el cálculo como artículos citables sin criterios claramente definidos. CiteScore es la ratio entre el número de citas recibidas en el año de cálculo por cualquier artículo publicado en la revista durante los 3 años anteriores56.

ConclusiónLos IB surgen de la necesidad de cuantificar la producción científica. Existen numerosas clasificaciones de IB, pudiéndolos dividir de forma práctica en índices de autores y grupos y en índices de revistas. Dentro de los índices de autores individuales, los más conocidos son el índice de Crown y el índice h, cuyas limitaciones principales son la temporalidad (lo que se intenta corregir con índices derivados como el índice e, el h5, el hc y el índice m) y la contribución individual de un autor en un artículo de autoría múltiple (que se intenta minimizar con el índice hw). También es importante valorar la trayectoria científica de un autor analizando sus índices de colaboración (tanto la tasa como el patrón de colaboración) para evaluar objetivamente su trayectoria científica. Pero en la mayoría de las ocasiones, para valorar la carrera científica de un profesional en todos los contextos (promoción dentro de la universidad, obtención de título de doctor, oposición o carrera profesional), los IB que determinan el baremo son los asociados a revistas. De ellos, el más extendido es el FI, que como hemos visto tiene muchas limitaciones y además puede manipularse desde un comité editorial. Aunque no es ético, existen revistas de una misma editorial o especialidad que pueden establecer una cierta “alianza” de citaciones lo que lleva a incrementar su factor de impacto. La misma empresa (Clarivate Analytics), consciente de sus limitaciones, creó otras métricas como el impacto ajustado a un campo de investigación, el eigenfactor y la influencia por artículo. Asociadas a Scopus tenemos el SJR y su derivado, el SJR2, el impacto por artículo normalizado por la fuente de la cita (SNIP) y el CiteScore. Todos estos IB tienen ventajas y limitaciones, por lo que evaluar la trayectoria investigadora de un profesional utilizando un único IB podría no ser fiel a la realidad y se puede sobreestimar e infraestimar. No existe un IB ideal, por lo que sería interesante que la trayectoria investigadora fuera juzgada por más de un índice métrico.

Autoría- 1.

Responsable de la integridad del estudio: CGV, JMGS.

- 2.

Concepción del estudio: CGV.

- 3.

Diseño del estudio: CGV.

- 4.

Obtención de los datos: No procede.

- 5.

Análisis e interpretación de los datos: No procede.

- 6.

Tratamiento estadístico: No procede.

- 7.

Búsqueda bibliográfica: CGV, JMGS.

- 8.

Redacción del trabajo: CGV, JMGS.

- 9.

Revisión crítica del manuscrito con aportaciones intelectualmente relevantes: JMGS.

- 10.

Aprobación de la versión final: CGV, JMGS.

Los autores declaran no tener ningún conflicto de intereses.