Este artículo recoge la problemática de la curva de Phillips bajo un tratamiento que desemboca en la curva de Taylor y en sus implicaciones generales. La primera sección aborda el debate Samuelson-Solow vs. Friedman-Phelps y el “cierre” Lucas-Sargent-Taylor, la segunda se dedica a la teoría de la inflación y la estabilización y la tercera revisa de manera no técnica los fundamentos que culminan en la curva y el trípode de Taylor. Al final se presentan algunas conclusiones.

This paper describes the issue of the Phillips curve under a treatment that leads to the Taylor curve and its general implications. The first section deals with the Samuelson-Solow vs. Friedman-Phelps discussion and the “closing” Lucas-Sargent-Taylor; the second is devoted to the theory of inflation and stabilization and the third review the nontechnical foundations culminating in the Taylor curve and the Taylor trinity. Finally some conclusions are obtained.

Por “dicotomía clásica” suele entenderse en el análisis económico la distinción analítica entre variables nominales y variables reales enfatizada por los fundadores británicos y escoceses de la tradición del siglo xvm que después llamaríamos “clásica”, una distinción que les permitía diferenciarse de la corriente mercantilista. Los clásicos y los mercantilistas sostuvieron polémicas tan prolongadas como la progenie que les siguió: “bullionistas”, escuela monetaria, neoclásicos, monetaristas, etc., versus “antibullionistas”, escuela bancaria, realbillers, keynesianos, etc., hasta que la llegada de la hipótesis de las expectativas racionales reacomodó los campos doctrinales forjando nuevos.

Precisamente: por política monetaria “moderna” puede entenderse aquella que se define en términos de su aceptación o rechazo a la hipótesis de las expectativas racionales, es decir, a su incorporación de expectativas endógenas en términos no orales (“espíritus animales” en su expresión primigenia) sino formales (funciones de densidad de probabilidad, y demás), al margen de si esta incorporación asume de manera indistinta supuestos inerciales o racionales (nuevos keynesianos) o estrictamente racionales (nuevos clásicos). Además, mientras para la tradición clásica y sus herederos la inflación es un fenómeno monetario, para sus competidores es un fenómeno no sólo monetario.

Tomando en consideración estas discrepancias no menores, el presente artículo revisa su formulación más o menos reciente partiendo de la curva de Phillips y arribando a la curva de Taylor y sus versiones contemporáneas, habida cuenta de que diversos bancos centrales, como el Banco de México, han interiorizado su metodología; algunos incluso hasta el punto de extenderla a las políticas monetarias no convencionales hoy en boga, como la Reserva Federal de Estados Unidos. La primera sección aborda el debate Samuelson-Solow vs. Friedman-Phelps y el “cierre” Lucas-Sargent-Taylor, la segunda se dedica a la teoría de la inflación y la estabilización y la tercera revisa de manera no técnica los fundamentos que culminan en la curva y el trípode de Taylor. Alguna conclusión se presenta luego de todo eso.

ICurva de Phillips, tasa natural y expectativas racionalesLa idea de que en el largo plazo las variables nominales y las reales son independientes unas de las otras se expresa, en el ámbito monetario, con la proposición de que la emisión de dinero no puede modificar la trayectoria del producto potencial o la del empleo en su magnitud de largo plazo, y se incorpora a los modelos como el postulado de neutralidad monetaria, postulado sobre el cual parece existir un consenso relativamente amplio. Para el corto plazo, no obstante, sí existe una cierta interacción entre el dinero y la producción (o el empleo), que ha sido documentada desde poco antes de los orígenes de la tradición clásica por numerosos personajes de distinto signo: John Law, David Hume, Henry Thornton, Thomas Attwood, John Stuart Mill, Irving Fisher, Jan Tinbergen, Lawrence Klein, etc.

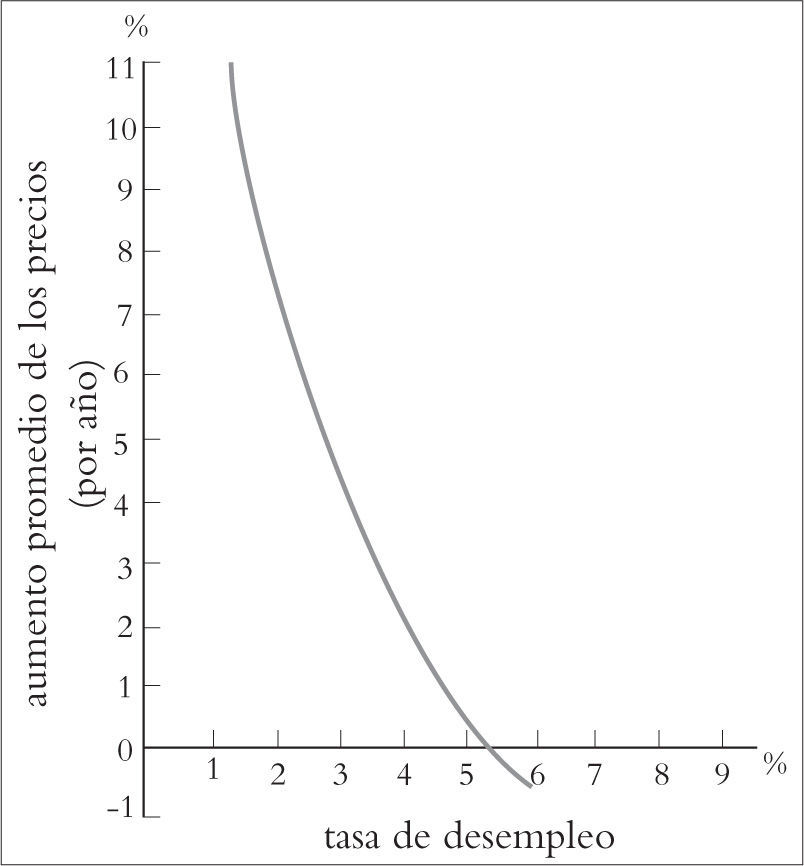

Pero fue el trabajo del economista neozelandés A.W. Phillips sobre estas variables el que tuvo gran repercusión luego de que Paul Samuelson y Robert Solow trasladasen sus hallazgos sobre Reino Unido a suelo estadounidense. Phillips había encontrado que durante el período 1861-1857, exceptuando las guerras, la relación inversa entre los salarios monetarios y la tasa de desempleo había sido tremendamente estrecha (a mayor desempleo menores salarios monetarios, y viceversa), pudiéndose representar, por lo tanto, como una curva con pendiente negativa. La repercusión aludida fue doble: en el aparato téorico –todavía en construcción de cimientos– de la llamada “síntesis neoclásica” de los keynesianos originada, sobre todo, en los propios Samuelson y Solow más James Tobin y Franco Modigliani, por un lado, y en la política macroeconómica de la potencia vencedora de la segunda guerra mundial, por otro.

Mediante el supuesto de que la tasa de crecimiento del salario menos la tasa de crecimiento de la productividad arrojaban un proxy de la inflación, Samuel y Solow (1960) tradujeron la relación al caso de Estados Unidos con algunos ajustes adicionales (adicionales al cambio en el explicandum del eje vertical: inflación por salarios monetarios). El primero consistió en “agrandar” la variable explicativa y añadirle (sumarle) un vector de variables que recogiesen y explicasen las desviaciones observadas. Ya no era el desempleo el que “explicaba” al salario monetario sino la demanda agregada excesiva (mercado laboral más mercado de bienes en desequilibrio) y otros factores (digamos un vector “z”) como el poder sindical o empresarial o el cambio en precios relativos lo que explicaba a la inflación.

Esta ampliación fue muy bien recibida entre los economistas keynesianos porque permitía que la inflación se separase del postulado clásico (“la inflación es siempre y en todo lugar un fenómeno monetario”, en palabras de Milton Friedman) y adquiriese una doble (o múltiple) naturaleza. Podía ahora la inflación explicarse por una demanda excesiva originada en políticas monetarias y/o fiscales (la inflación por jalón de demanda) o por los otros factores mencionados (monopolios, sequías, etc.) no controlables por la autoridad monetaria (la inflación de oferta o por empuje de costos). Y en este segundo caso estarían justificadas las políticas de ingresos, es decir, el congelamiento extramercado de precios y salarios vía acuerdos entre las partes inducidos con firmeza por el gobierno central o federal.1

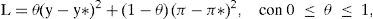

Una vez que las políticas de ingresos podían desplazar la curva hacia el origen en el biplano, el segundo ajuste fue el de suponer que la economía podía moverse a lo largo de esa nueva curva de Phillips, obteniéndose así un posible menú de políticas controlable por las autoridades: habría pues una relación estructural que permitiría conseguir una cierta tasa de desempleo (tasa que representaría un indicador concentrado de las variables aludidas) a una cierta tasa de inflación y, otra vez, viceversa. A esta relación, que suponía entonces un trade-off (o juego de suma cero) –explotable por la autoridad– entre desempleo e inflación, se le conoció como la curva de Phillips de Samuelson-Solow,2 y tuvo como base empírica los datos de la economía de Estados Unidos de los años 1900 a 1930 y 1946 a 1958 (véase Gráfica 1).

Curva de Phillips modificada para Estados Unidos

Las réplicas de Milton Friedman y de Edmund Phelps a estas ideas sobre la inflación procedieron de lecturas del mercado monetario y del mercado laboral, respectivamente, pero confluyeron en varios puntos clave. Partiendo de un enfoque clásico reiteraron que la inflación era un fenómeno monetario, y las correlaciones observadas se explicaban por la no neutralidad clásica, esto es, por choques originados en el sector monetario de la economía, responsabilidad del banco central, y no en el sector real (cambios en la productividad y otros), que afectaban más bien a los precios relativos. Además, admitir la explotabilidad de la relación inflación-desempleo supondría la existencia de velo monetario, consecuencia a su vez de suponer que los agentes podían ser engañados de manera sistemática.

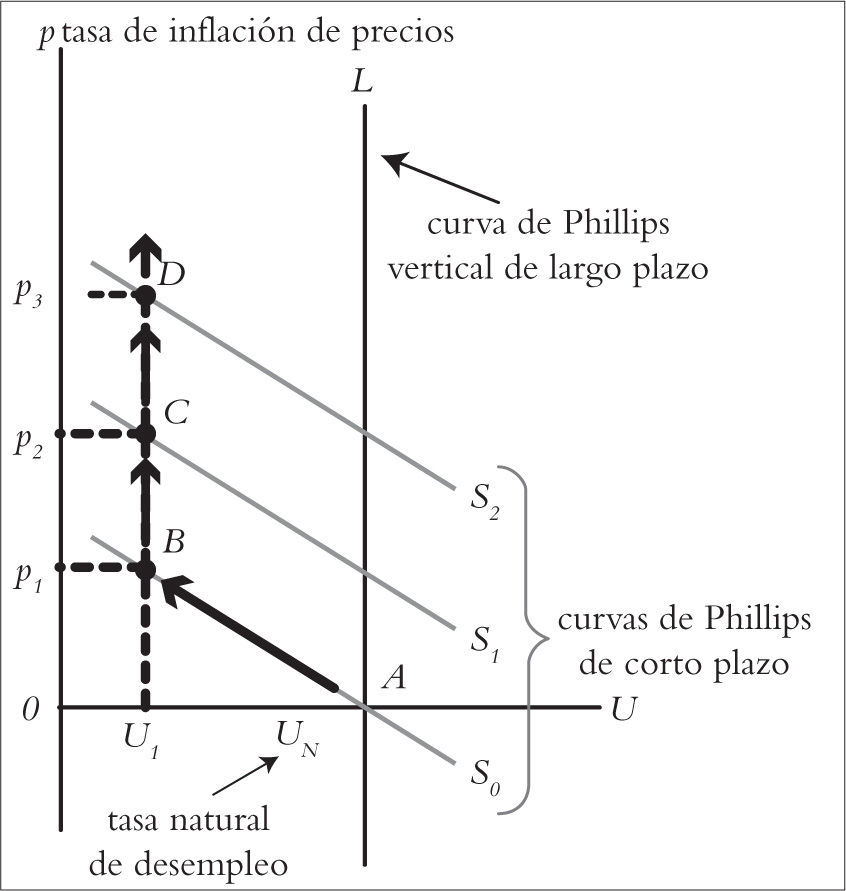

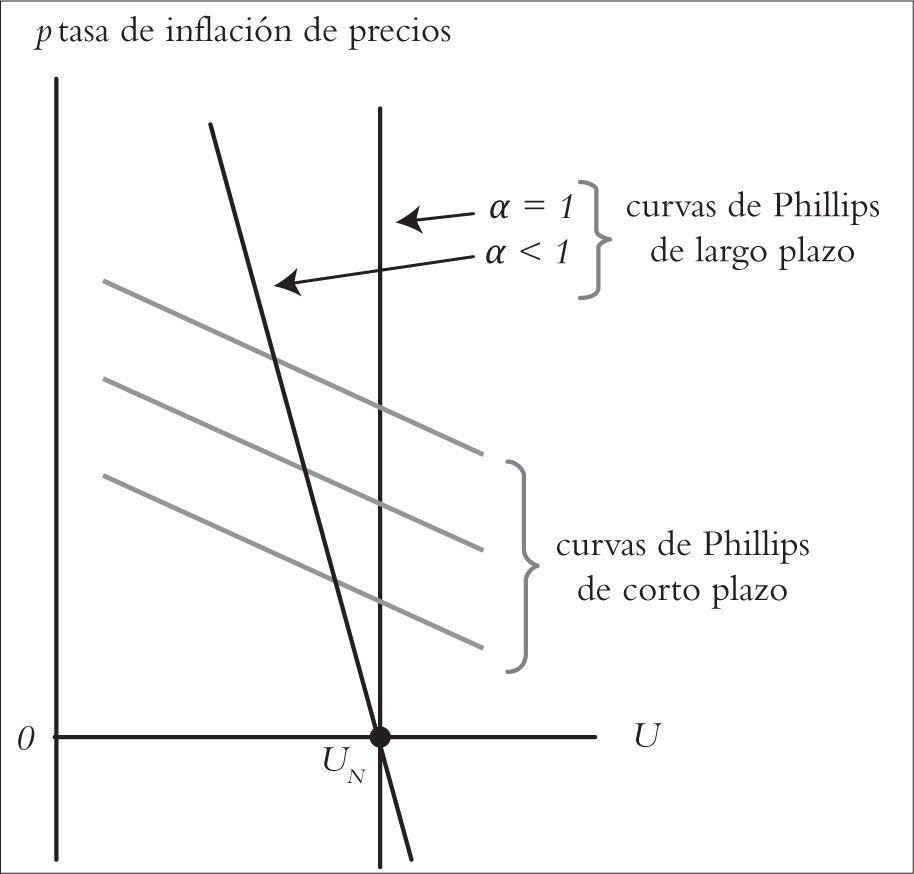

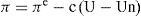

Pero si los agentes no se guiaban por los incrementos salariales nominales sino por su bienestar real (el salario nominal menos la inflación esperada), sus expectativas se ajustarían ante cada cambio de política que intentase desplazar a la economía (hacia arriba) sobre la curva de Phillips de Samuelson-Solow a fin de obtener una menor tasa de desempleo, es decir, se generaría en realidad una nueva curva (de corto plazo), más lejana al origen, que evidenciaría el carácter endógeno (adaptativo, en este caso) y no exógeno (estático) de las expectativas. Esto generaría el regreso constante del desempleo observado a una tasa de desempleo promedio (la tasa “natural”), a partir de cuyo valor podría trazarse una paralela al eje vertical (una curva de Phillips de largo plazo). De modo que una tasa blanco de desempleo menor a la natural sólo sería posible generando sorpresas continuas que acelerarían la inflación (véase Gráfica 2con U1 como blanco de la tasa de desempleo).

Curvas Phillips con tasa natural y corolario aceleracionista

Por cuanto la tasa natural de desempleo sería la tasa prevaleciente cuando la economía se encontrase en equilibrio (entendido como la producción real creciendo a su nivel potencial), la inflación de Friedman-Phelps se determinaría por la desviación del desempleo respecto de su tasa natural más la inflación esperada por los agentes (cuando el desempleo observado igualase al natural la inflación observada sería igual a la esperada). Pero la diferencia crítica respecto de Samuelson-Solow no sólo se observaría en el peso que ahora tendrían las expectativas inflacionarias de los agentes, sino en que la desviación del desempleo se originaría básicamente en choques monetarios y la inflación esperada estaría asociada a la regla de política del banco central, es decir, la inflación sería otra vez un fenómeno monetario.

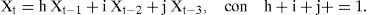

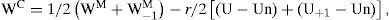

Sintetizando la problemática con un mínimo de formalización –en términos que siguen, con ajustes, a Humphrey (1985) – podría definirse la relación postulada por Phillips como

donde W es el salario monetario y U es la tasa de desempleo; la reformulación de Samuelson-Solow quedaría como donde π es la tasa de inflación, b(U) es la demanda excesiva de los mercados de bienes y servicios, etc. (o el inverso de la tasa de desempleo), a es un coeficiente de reacción (cuánto cambian los precios cuando la demanda excesiva varía), z es un vector de variables que incluye al poder de los monopolios, la combatividad sindical y diversos choques reales como inundaciones, etc., w es la tasa de crecimiento de los salarios monetarios y q es la tasa de crecimiento de la productividad; y la inflación de Friedman-Phelps seríadonde πe es la inflación esperada, c es un coeficiente de ajuste y Un es la tasa de desempleo natural, es decir, si se le restase la inflación esperada a la observada y el saldo no fuese cero se trataría de una sorpresa inflacionaria que se asociaría a una desviación del desempleo observado respecto del natural.Ahora bien, la versión Samuelson-Solow de la curva estipulaba una inflación de demanda y una de costos, con orígenes variados: monetarios, fiscales, institucionales, reales, con un trade-off entre niveles de la inflación y niveles de desempleo, y la versión Friedman-Phelps restituía su carácter monetario asentada en tres conceptos ausentes en los keynesianos: las expectativas adaptativas, la tasa natural de desempleo y su corolario aceleracionista, con un trade-off entre sorpresa inflacionaria (la desviación de la inflación esperada respecto de la observada) y la desviación del desempleo observado respecto del natural, pero cuando las cosas parecían darle la razón teórica a la dupla monetarista se presentó un problema nuevo.

El nuevo problema, que abriría el camino para desarrollos un poco más técnicos, consistía en que la ecuación de Friedman-Phelps suponía un coeficiente de 1 en la variable de expectativas inflacionarias, que podría representarse por α : α.πe. Eso garantizaba que la curva de corto plazo (ya reinterpretada en términos clásicos) embonaba con la de largo plazo (con neutralidad monetaria): cuando en el largo plazo los agentes adaptativos no pudiesen ser sorprendidos en la tasa de inflación a valdría precisamente 1, y la ecuación resultante a partir de la ecuación 3 podría despejarse para la inflación observada:

pero si a era menor que 1 habría también un trade-off en el largo plazo, porque la curva de largo plazo tendría una pendiente ligeramente negativa (y no habría neutralidad monetaria), por lo que la hipótesis de la tasa natural quedaría severamente debilitada.Y eso fue lo que sucedió. El llamado “problema de las alfas” consistió en que las evaluaciones empíricas arrojaban un valor menor que 1, y el avance teórico no se veía validado por los test estadísticos. Es entonces cuando Robert Lucas y Thomas Sargent, con diferentes procedimientos, mostraron que la hipótesis de tasa natural era pertinente pero que las estimaciones estaban basadas en expectativas endógenas de tipo adaptativo, las cuales suponían que el valor esperado de una variable durante el período en curso estaba determinado por los valores pasados de la propia variable ponderados decrecientemente por parte de los agentes. Un ejemplo simple podría ser del tipo siguiente:

La magnitud de los coeficientes (h, i y j) que acompañan a los valores pasados de la variable a predecir (X en el período t) tendría que reflejar un orden geométricamente decreciente (0.85, 0.12 y 0.03, por ejemplo), pero esta manera de endogenizar las expectativas en términos cuantitativos era más parecida a un algoritmo ad hoc que a un procedimiento analíticamente fundamentado, en opinión de Lucas y Sargent. Ellos propusieron en varios artículos una endogenización de expectativas que utilizara el concepto de John Muth: las expectativas racionales, que rápidamente mostró coherencia teórica y pertinencia empírica con la tasa natural. Intuitivamente suele decirse que el agente racional posee dos características: una, utiliza con eficiencia toda la información disponible, a fin de pronosticar la variable que le interesa y, en segundo lugar, no comete errores sistemáticos.

Se infiere con lo anterior que este agente, en promedio, acierta, y trata de adelantarse a los acontecimientos (una baja futura en el precio de la energía, digamos, es descontada de inmediato por él en su portafolios de inversión), pues si en promedio se equivoca terminará saliendo del mercado. Como puede verse, el concepto de Muth –de índole no prescriptiva sino descriptiva– era muy simple pero de grandes repercusiones como técnica de modelación: la manera en que los agentes individuales forman sus expectativas (su distribución de probabilidad subjetiva) puede igualarse con la manera como la teoría relevante pronostica, dada la información disponible al momento de hacer el pronóstico (la distribución de probabilidad objetiva):

donde Xe es expectativa de la variable a pronosticar en el período t + k, E es el operador de expectativas e I es la información disponible en el período t (Muth, 1961).3Poniendo en marcha el concepto de Muth para la macroeconomía Sargent publicó un trabajo muy largo en la revista de la Brookings Institution (Sargent, 1973) y uno muy corto y preciso donde abordó el “problema de las alfas” (Sargent, 1971), y Lucas presentó una sonada evaluación econométrica de la hipótesis de la tasa natural con agentes racionales en un coloquio especializado –luego publicado en Washington (Lucas, 1972b) – y un modelo de equilibrio general estocástico que no sólo incorporaba los supuestos clásicos y monetaristas: tasa natural de desempleo, la inflación como fenómeno no real sino monetario, no neutralidad de corto plazo originada en problemas de información, etc., sino también agentes racionales, un enfoque de generaciones traslapadas utilizado en otro contexto por Samuelson, y demás (Lucas, 1972a).

Estos trabajos fueron apenas el comienzo de una enorme ola, marcando la pauta para que la hipótesis de expectativas racionales de Muth entrase de lleno a casi todos los debates más connotados en los años setenta (y después) y abriendo una nueva etapa en la prolongada controversia que enfrentaba a los monetaristas (herederos de los clásicos) con los keynesianos (herederos de los mercantilistas) sobre la dicotomía clásica –reestableciendo los vínculos entre el dinero, la inflación y el producto. La aplicación cuidadosa y, sobre todo, contrastable, de la hipótesis de Muth dio lugar a tres grandes replanteamientos o implicaciones: la crítica de Lucas (en la econometría), la proposición de inconsistencia dinámica (en la política económica) y los teoremas de irrelevancia (en la teoría económica).

IITeoría de la inflación y estabilizaciónDe entre las implicaciones de la hipótesis de los agentes racionales en la macroeconomía destacaron los llamados “teoremas de irrelevancia”. Éstos no eran más que revisiones muy formalizadas de viejas aseveraciones keynesianas pero cuyo saldo llamativo radicaba en que disminuían el poder del gobierno sobre la economía, o al menos el poder que los keynesianos le atribuían. Quizá el más connotado de dichos teoremas lo fue un resultado obtenido por Sargent y Neil Wallace acerca de la posibilidad de que las variables nominales como el dinero no pudieran afectar variables reales, como el producto, ni siquiera en el corto plazo. Si tal cosa sucedía se verificaba la “proposición de inefectividad”.

El ensayo de Sargent y Wallace (1975), ya en el contexto de una tasa natural triunfadora, se basaba en una curva de oferta en la que Lucas había combinado el desempleo natural con la hipótesis de Muth: “[t]odas las formulaciones de la teoría de la tasa natural postulan agentes racionales, cuyas decisiones dependen solamente de precios relativos, colocados en un escenario económico en el cual no pueden distinguir movimientos de los precios relativos de movimientos de los precios generales”, por lo que aumentos no esperados en el nivel general de precios son leídos por esos agentes como aumentos en los precios relativos de los bienes que ellos producen, lo que incentiva la producción (Lucas, 1973). Esta es la explicación de las correlaciones observadas en el corto plazo entre la inflación y el producto (o el desempleo, cuando las correlaciones son inversas) que forman ese tipo de curvas de Phillips.4

El modelo en sí trataba de mostrar cómo una estructura keynesiana a la que se le agregaban características clásico-monetaristas terminaba nulificando los resultados que originalmente predecía. Sargent y Wallace, de hecho, se expresan con cierto desdén de la modelación keynesiana: afirman que son modelos ad hoc, en el sentido de que no están microfundamentados, lo que es una “característica deplorable”. Incluso se preguntan si las conclusiones de un modelo ad hoc con una función de pérdida también ad hoc pueden tomarse en serio. Lo serio en verdad, dicen, es que el modelo tiene agentes racionales y curva de oferta de Lucas, pero su enfoque puede modelarse igualmente con otras características clásicas y monetaristas, como en el siguiente caso muy sencillo.5

Consideremos una curva de Phillips Friedman-Phelps basada en la ecuación (3)

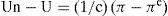

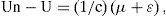

una inflación clásico-monetarista donde m es la tasa de crecimiento monetario y ε es un error aleatorio con media cero; la autoridad, por su parte, reacciona con una herramienta clásica (emisión monetaria) ante una brecha de desempleo (la diferencia entre el desempleo pasado y el blanco de desempleo) y una brecha inflacionaria (la diferencia entre la inflación pasada y el blanco inflacionario) más un error aleatorio (μ) con media cero las expectativas inflacionarias son racionales y al aplicar expectativas matemáticas en las ecuaciones (8) y (9) tendremos y substituyendo (9) en (8) y (12) en (11), y retomando (7), obtendremos donde las desviaciones del desempleo observado respecto del natural únicamente se originan en choques, ya sea provenientes del sector monetario (me – m = μ) o de errores de pronóstico que indican que la autoridad se desvió de su tasa de emisión monetaria o que hubo algún otro evento no esperado (π – πe = ε).Parafraseando a Sargent y Wallace podría decirse que la razón por la que la variable real (el desempleo) es independiente de la parte sistemática de la política (la regla monetaria contenida en la ecuación 9) se encuentra en que la autoridad monetaria, siempre que quiera reducir el desempleo observado, deberá generar movimientos no esperados en el nivel de precios (dada la ecuación 7), pero como las expectativas inflacionarias son racionales (según la ecuación 10) –lo que implica que las autoridades y el público dispondrán de la misma información– la parte no esperada de las fluctuaciones de los precios es independiente de la parte sistemática de la oferta monetaria. “No existe regla sistemática que las autoridades puedan seguir que les permita afectar la parte no esperada del nivel de precios”.

Ciertamente, las autoridades podrían incorporar un término no predecible a su regla a fin de obtener no-neutralidades de corto plazo capaces de romper la proposición de inefectividad resultante (emprender políticas contracíclicas con verdadera capacidad de afectar variables reales), pero, debido a los costos en los cuales incurriría, no pareciera que una buena relación del gobierno con los agentes económicos, que es siempre una relación de largo plazo, pudiera o debiera basarse en eso. El desafío quedaba a la vista: la incorporación de tasa natural y agentes racionales a los modelos keynesianos conllevaba un teorema de irrelevancia (la proposición de inefectividad, en particular). Para bien y para mal la lectura corriente fue que Sargent y Wallace lo postulaban para todo esquema contracíclico.

En temáticas diferenciadas pero finalmente conexas varios economistas keynesianos replicaron a lo largo de los siguientes años a este desafío: John Taylor, Stanley Fischer, Rudiger Dornbusch, Guillermo Calvo, Julio Rotemberg, etc. En particular Taylor comenzó a construír una gran cantidad de modelos en los cuales no se obtenía una proposición de inefectividad, a pesar de adoptar gran parte de los supuestos ya comentados (agentes racionales, tasa natural, regla monetaria, etc.), excepto uno: los precios y los salarios no eran perfectamente flexibles debido a que los contratos firmados entre los patrones y los sindicatos, siendo multiperiódicos, se traslapaban, inoculando factores de inercia inflacionaria. Los modelos de Taylor fueron sumamente exitosos, sobre todo al reforzarse con empiria creciente en cada nueva pieza de investigación.6

Pero no todos los keynesianos aceptaron modelar con la hipótesis de expectativas racionales. La división keynesiana motivó dos nuevos rótulos en el casillero de la teoría económica (luego vendrían varios rótulos más, directa o indirectamente derivados también de esta controversia). Aquellos keynesianos que, como James Tobin, defendieron su tradición de intromisiones probabilísticas indeseables y lo que vendría con ellas (que fue muchísimo) pasaron a la categoría de “viejos keynesianos”, mientras los “nuevos keynesianos” no sólo las aceptaron sino que se sumaron como figuras descollantes a su intenso desarrollo matemático, en una línea de trabajo que -aun con oscilaciones- no tendría marcha atrás durante tres décadas, hasta que la gran recesión de 20082009 sembraría dudas en algunos de ellos. En la naciente tipología Lucas, Sargent y sus colegas pasarían a ser llamados “nuevos clásicos”.

La respuesta a la proposición de inefectividad fue muy amplia, como ya se dijo. Tobin y muchos otros la hicieron objeto de agudas observaciones teóricas y hasta de ironías literarias. Se dijo, por ejemplo, que esa macroeconomía (la de la proposición de inefectividad, como representando la línea de los nuevos cásicos) era la del Dr. Pangloss, un jocoso personaje de Voltaire para el cual todo lo dado (lo real), por más absurdo que pareciera, era necesario (racional), y otras cosas por el estilo (Buiter, 1980). Pero fue quizá John Taylor quien mejor y más persistentemente convirtió con prontitud la cruzada genérica en crítica singularizada, apuntó al corazón técnico y obtuvo resultados dignos de mención.

Era posible, ciertamente, estipular un resultado no clásico en una economía keynesiana, tal como Sargent y Wallace estipularon uno clásico a través de una curva de oferta agregada tipo Lucas. Para demostrarlo Taylor partió del nuevo consenso: el corolario aceleracionista de Friedman-Phelps, que incluía una curva de Phillips vertical en el largo plazo, haciendo hincapié en que las propiedades dinámicas de la inflación esperada se obtendrían del carácter endógeno de las expectativas y de la naturaleza de los contratos imperantes: “[e] l impacto de la demanda agregada sobre la inflación y el empleo es crucialmente dependiente de si el mecanismo de los contratos o el mecanismo de las expectativas domina los efectos de persistencia” (Taylor, 1979a).

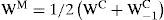

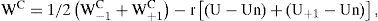

Dado que el elemento más ostensible de los contratos es que no se firman de manera simultánea y con la misma duración sino que se traslapan unos con otros, esta característica puede captarse de un modo simple suponiendo que la mitad de los contratos se firma en enero y la mitad en julio.7 Si el salario medio (WM) se determina por el salario contractual presente (WC) y pasado (WC-1) y el salario contractual (WC) se determina, a su vez, por el salario medio esperado y por las brechas de desempleo, tendremos

y donde r es un parámetro que indica cuánto responde el salario contractual al desempleo y, complementariamente, las brechas de cada período se forman contra la tasa natural favoreciendo (o no) que el salario contractual suba (o baje) más que el medio si el desempleo natural será más alto que el observado.Si se substituye la ecuación 14 en la 15 y se reagrupan los términos obtendremos

que indica que los salarios contractuales pasado y futuro determinan el salario contractual presente así como también lo hacen las brechas de desempleo presente y futura. El salario contractual pasado incorpora la inercia, la parte adaptativa, pues implica que los trabajadores firman hoy tomando en cuenta lo que firmaron ayer, pero el salario contractual esperado (el futuro) entra también en la determinación del salario contractual en curso (el presente). En el caso del mercado laboral lo que cambia es que la tasa natural de desempleo es el factor de contrastación tanto del presente como del futuro, pero si se pronostica una recesión (mayor desempleo futuro) el salario contractual vigente será afectado por una brecha negativa mayor ponderada por el parámetro r.Las implicaciones de esta representación (del libro de texto de Taylor) para la dicotomía clásica y, en específico, para la cuestión de la no neutralidad de corto plazo son rotundas. Bajo el supuesto de un margen precios-costos fijo, la ecuación permite estipular que las variaciones salariales se traduzcan en variaciones en los precios, a la manera de Samuelson-Solow, a fin de cuentas. Además, una regla monetaria creíble mejora el trade-off inflación-desempleo, porque significaría que ante presiones inflacionarias futuras (WC+1 más alto) el alza se compensará con mayor desempleo futuro (U+1 más alto) en proporción tal que deje sin cambio el salario contractual presente (WC), dado el valor de r, y deje también sin cambio el desempleo presente.

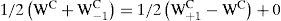

¿Y qué pasaría con el trade-off en el largo plazo? El modelo predice que una variación inflacionaria constante y anticipada tendría que conducir a una curva de Phillips de Friedman-Phelps, es decir, a una curva de largo plazo vertical susceptible de interactuar con una ecuación de demanda agregada. La ausencia de trade-off se explicaría del modo siguiente: si el salario contractual se mantiene constante, su variación de este año y la del próximo (pequeña o grande, no importa) tendrían que ser la misma; digamos:

con el desempleo presente y futuro a su nivel natural, por lo que sus brechas sólo podrían ser cero. Este último supuesto sobre el comportamiento del mercado laboral retomaría la tradición clásica que Friedman, Phelps y Lucas habían revivido (y que Buiter considerara una macroeconomía panglossiana).El saldo neto de esta disputa se solidificó en dos vertientes. La primera estableció la llamada “teoría moderna de la inflación” seguida por casi todos los bancos centrales del mundo, y puede verse en la mayoría de libros de texto de macroeconomía, con algunas derivaciones específicas como las políticas heterodoxas de estabilización. La segunda vertiente, objeto del tercer inciso de este trabajo, arrancó con la curva de Taylor –que retomó el trade-off de la dicotomía clásica– y “culminó” en el trípode de Taylor, que estipula de qué se compone una buena política monetaria moderna de largo plazo. Ese es un mapa básico, para nada exhaustivo, de los incontables vericuetos que van arribando a la política monetaria moderna, siempre en un contexto que privilegia la tensión contenida en la dicotomía real-nominal.

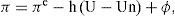

En la primera vertiente los nuevos keynesianos terminaron construyendo su curva de Phillips con tres componentes del lado derecho de la ecuación: a) asumieron la curva de oferta de Lucas (en la línea monetarista-nuevoclásica) pero la ajustaron vía la “ley” de Okun (en la línea nuevokeynesana), b) mantuvieron los choques de Samuelson-Solow (en la línea viejo keynesianamercantilista) y c) le incorporaron las expectativas endógenas formalizadas (en la línea monetarista-nuevoclásica).8 Esta mezcla doctrinal asaz peculiar operó así: a) Arthur Okun, economista estadounidense que fue asesor de varios presidentes de su país, encontró una relación estadística inversa entre las variaciones del producto y las variaciones del desempleo, en la que la regresión resultante permitía suponer una asociación intensa, lo que pasó a llamarse “la ley de Okun”, y era relativamente equivalente a la curva de Lucas si se despejaba para T y se hacía ostensible la resta del producto natural al observado.9

Entonces, en la inflación esperada (inciso c) que quedaba del lado derecho era posible suponer, aun con agentes racionales (cosa moderna), algún grado de persistencia inflacionaria debida a contratos traslapados y, dado que la teoría económica (post Simon-Theil, sobre todo) es fundamentalmente probabilística,10 se le podía agregar sin problema un choque (0) con media cero que reflejase las preocupaciones de Samuelson y Solow por factores como las sequías y otros ya mencionados (inciso b):

quedando una teoría moderna de los procesos inflacionarios apoyada en una explicación no clásica de la inflación pero sí con elementos clásicos: ahí había lugar para una inflación inercial (π = πe, si suponemos un valor de cero en los demás componentes), para una inflación por jalón de demanda [π = – h (U - Un), con valor de cero en los demás componentes] y para una inflación por empuje de costos (π = φ, con valor de cero en los demás componentes).La inflación dejaba de tener un origen monetario (nominal) exclusivo para tenerlo también en la productividad y demás factores no nominales sino reales. La inflación de demanda agregada, en la medida en que se explica aquí por las políticas fiscales y monetarias, regresaba a Samuelson-Solow, pero se separaba de ellos en su lectura de las políticas de ingresos. Mientras ellos habían propuesto tales políticas para resolver ciertos problemas observados en la inflación por costos, ahora algunos nuevokeynesianos heterodoxos las proponían sólo para combatir el componente inercial de la inflación. Cuando no hay choques del lado de la oferta y se han apagado los motores fiscales y monetarios, la inflación remanente -afirman los estabilizadores heterodoxossólo puede originarse en el primer término del lado derecho de la ecuación 18,11 lo cual puede entenderse mejor con herramientas de la teoría de juegos. Más claro: “[e]l punto esencial de la teoría moderna de la inflación es el reconocimiento de que la inflación está vinculada al pasado a través de una variedad de canales. No es solamente «demasiado dinero persiguiendo muy pocos bienes», lo cual es el segundo término [de una ecuación como la 18, HC], o choques de oferta como los incrementos de precios petroleros o agrícolas, o la depreciación real, sino el hecho simple de que inflación ayer significa inflación hoy” (Dornbusch y Simonsen, 1988). Una diferencia adicional de la estabilización heterodoxa con el enfoque nuevokeynesiano estándar radica entonces en que cambian el origen de la inercia inflacionaria: reemplazan el mecanismo de los contratos traslapados, incluso con agentes racionales en el estilo Fischer-Taylor, por factores propiamente institucionales, como la indización salarial; de modo que en la ecuación (18) la variable “inflación esperada” se substituye por la “inflación originada en los incrementos salarios” (wπ).

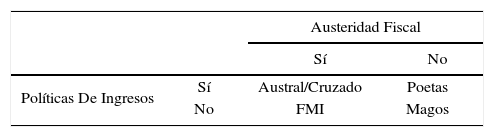

Los heterodoxos, finalmente, no rechazan la pertinencia de la disciplina fiscal para la estabilización sino lo que consideran el error fondomonetaris-ta: centrarse sólo en mayor desempleo observado sobre el natural –vía las restricciones (fiscal-monetarias) de la demanda agregada– como mecanismo anti-inflacionario en vez de apoyarse también en las políticas de ingresos –que incluyan congelamiento del tipo de cambio y remonetización– para atacar la inercia que viene del primer término. Eso impone mayor sufrimiento social y abre la puerta para que los populistas ganen las siguientes elecciones, rompan la austeridad presupuestaria y adopten congelamientos desordenados de precios y salarios. Al clasificar los programas ortodoxos y heterodoxo de ciertos países en gradualistas o de choque, ponen ejemplos de los heterodoxos de los dos tipos y de los ortodoxos gradualistas, y concluyen con sorna que “es más difícil recordar un ejemplo de un programa ortodoxo de choque, quizá debido a la escasez de sobrevivientes que puedan hacer el recuento del episodio” (Dornbusch y Simonsen, 1987).12

Estabilización ortodoxa, heterodoxa v “nodoxa”

| Austeridad Fiscal | |||

|---|---|---|---|

| Sí | No | ||

| Políticas De Ingresos | Sí | Austral/Cruzado | Poetas |

| No | FMI | Magos | |

La segunda gran vertiente que emanó de todas las disquisiciones mencionadas tiene como punto de partida la búsqueda de métodos para tomar en cuenta la manera como las expectativas interactúan con las políticas, búsqueda que tenía que tomar en cuenta la crítica de Robert Lucas a los métodos econométricos que operaban con coeficientes fijos en las funciones de reacción sin considerar los cambios en los regímenes de política. John Taylor enfrentó este conjunto de tópicos construyendo un modelo pequeño que le permitiese encontrar reglas de política para estabilizar variables reales y nominales (Taylor, 1979b). Esto significaba un tratamiento ya no positivo (como podía revisarse la teoría de la inflación) sino normativo, y tendría importantes consecuencias.

El modelo contenía una primera ecuación de demanda agregada tradicional y una segunda de determinación de precios con agentes racionales y corolario aceleracionista –una en la que no podía elevarse el producto permanentemente por encima de su tendencia sin acelerar la inflación–, es decir, la curva de Phillips era vertical en el largo plazo y en el corto no. Y las ecuaciones 3 y 4 describían “la estructura estocástica de los choques aleatorios”. Otras más formaban un modelo de promedio móvil (de vectores autorregresivos) con restricciones en los parámetros, y así por el estilo. Para la estimación, realizada por primera vez en 1976 y por segunda antes de que se publicara (en 1979), se usaron datos trimestrales del período que va de 1953 a 1975.

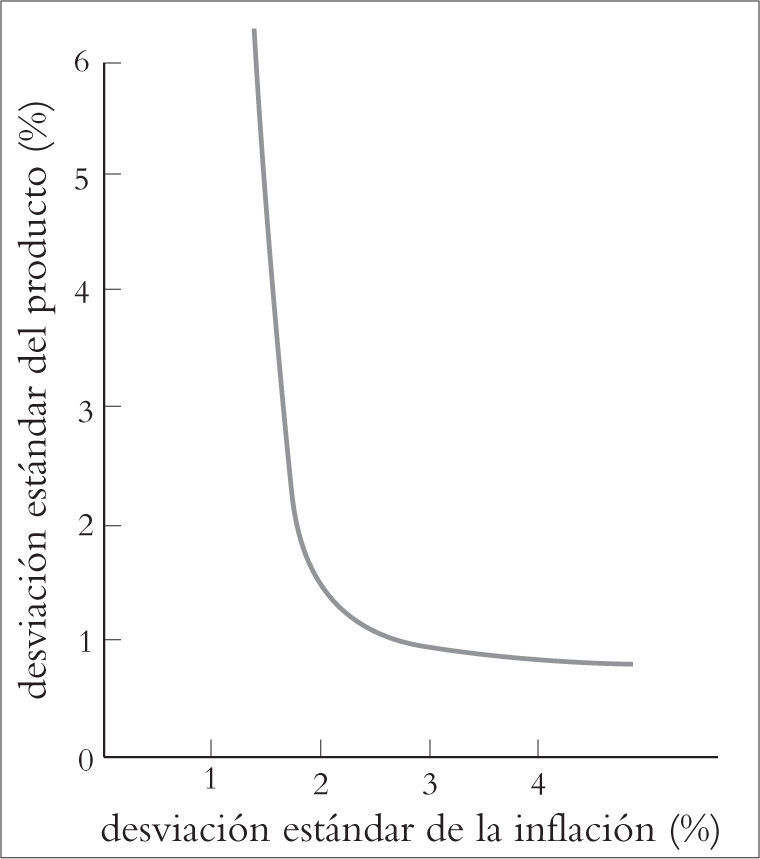

El ensayo de Taylor era técnico, y por ello calculaba reglas monetarias que fuesen incorporando la información que se generaba acerca del estado del mundo mediante procedimientos de control óptimo. Estas reglas con retroalimentación estaban diseñadas para reducir las fluctuaciones del producto y de la inflación respecto de sus niveles de referencia. Esto implicaba que la inflación tenía un blanco definido por la autoridad (π*) y que el nivel deseable del producto sólo podía ser aquel que no aceleraba la inflación (γ*). La función de pérdida (L) correspondiente quedaba como

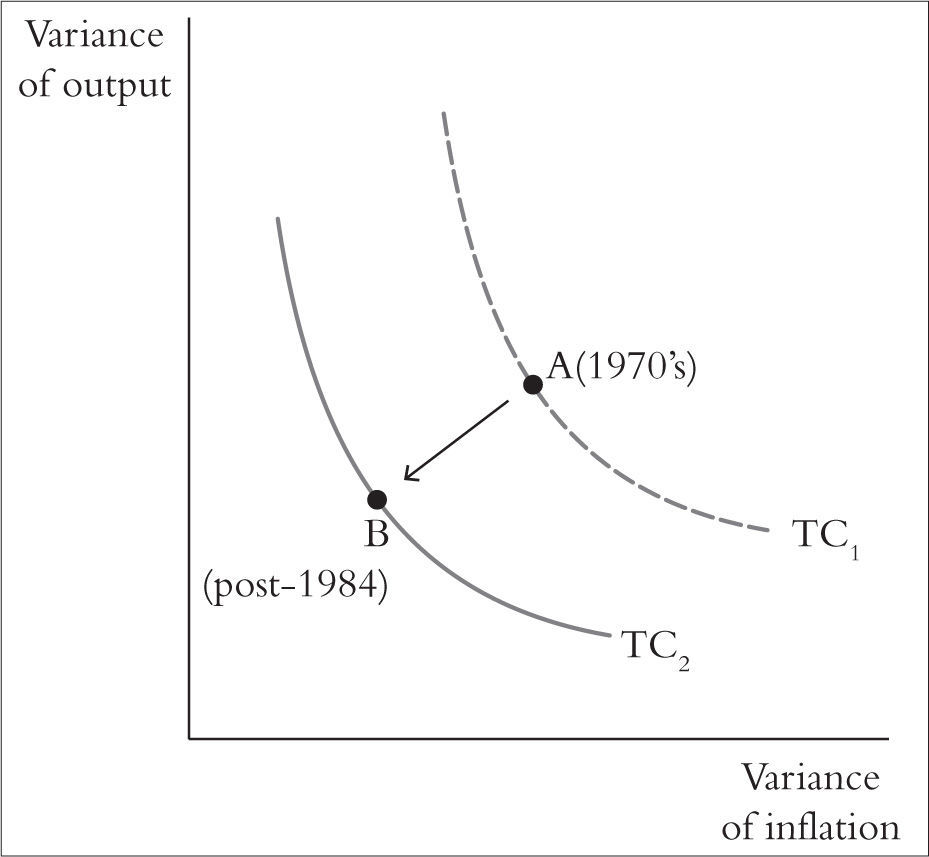

y la regla con retroalimentación sería una regla monetaria típica, es decir, con un agregado monetario como herramienta de intervención.Por esta vía se llegó a un resultado en verdad novedoso. Las pendientes de las curvas de Phillips de corto y de largo plazos no variaban, sin embargo se identificaba un trade-off de largo plazo entre las fluctuaciones (no los niveles) de la inflación y las fluctuaciones (no los niveles) del producto (véase Gráfica 4). “En otras palabras, existe una curva de Phillips «de segundo orden» que no es vertical en el largo plazo… El tradeoff entre estabilidad del producto y estabilidad de precios se caracteriza más fácilmente en términos de las desviaciones estándar del producto y de la inflación en este modelo.” (Taylor, 1979b). Como es obvio, estas conclusiones revivían la disputa por la dicotomía clásica en una dimensión todavía no explorada, pero llegarían para quedarse.

La situación se tornaba un tanto paradójica, porque Taylor, un autor de clara filiación nuevokeynesiana, había llegado a una nueva curva real-nominal con trade-off de largo plazo partiendo de casi todos los requisitos teóricos impuestos a los modelos por los seguidores de los clásicos (los monetaristas y los nuevoclásicos), excepto los contratos traslapados que conferían rigideces a los precios y a los salarios. Pero otras cosas resultaban polémicas: una conocida curva de varianzas de Lucas quedaba completamente invertida (Lucas, 1973), pero Taylor la invertía retomando una idea muy clásica, idea que “trata las fluctuaciones en el desempleo y otras variables como planteando un problema de políticas”. Para esta perspectiva las políticas no tienen que ocuparse de obtener niveles específicos de las tasas de ciertas variables sino de mitigar sus fluctuaciones.

Estas circunstancias tan especiales del trabajo de Taylor le permitieron después condensar las implicaciones de política obtenibles de la hipótesis de racionalidad de Muth en cinco principios generales, teniendo todavía, como leve telón de fondo, el fin del debate sobre la inefectividad de la política: primero, la gente mira hacia adelante, y sus expectativas pueden modelarse razonablemente bien si suponemos que se han comprendido las regularidades estadísticas del ciclo económico, por lo que hacen pronósticos insesgados. Segundo, la política macroeconómica debiera ser estipulada y evaluada como una regla, más que como cambios de una sola vez en los instrumentos de política.

La manera de conseguir los beneficios que otorga el uso de reglas es estableciendo un compromiso púbico con ella, y este es el tercer principio, que llama al gobierno a no ser inconsistente entre sus anuncios y sus políticas futuras (alejarse de la inconsistencia dinámica).13 Y los últimos dos principios son quizá un poco más discutidos: cuarto, después de un choque la economía (el producto, el empleo) regresará a su trayectoria tendencial porque es básicamente estable. Pero el regreso puede ser lento debido a rigideces de la estructura económica. Y quinto: el objetivo de la política macro es reducir el tamaño o la longitud de las fluctuaciones durante períodos largos.14

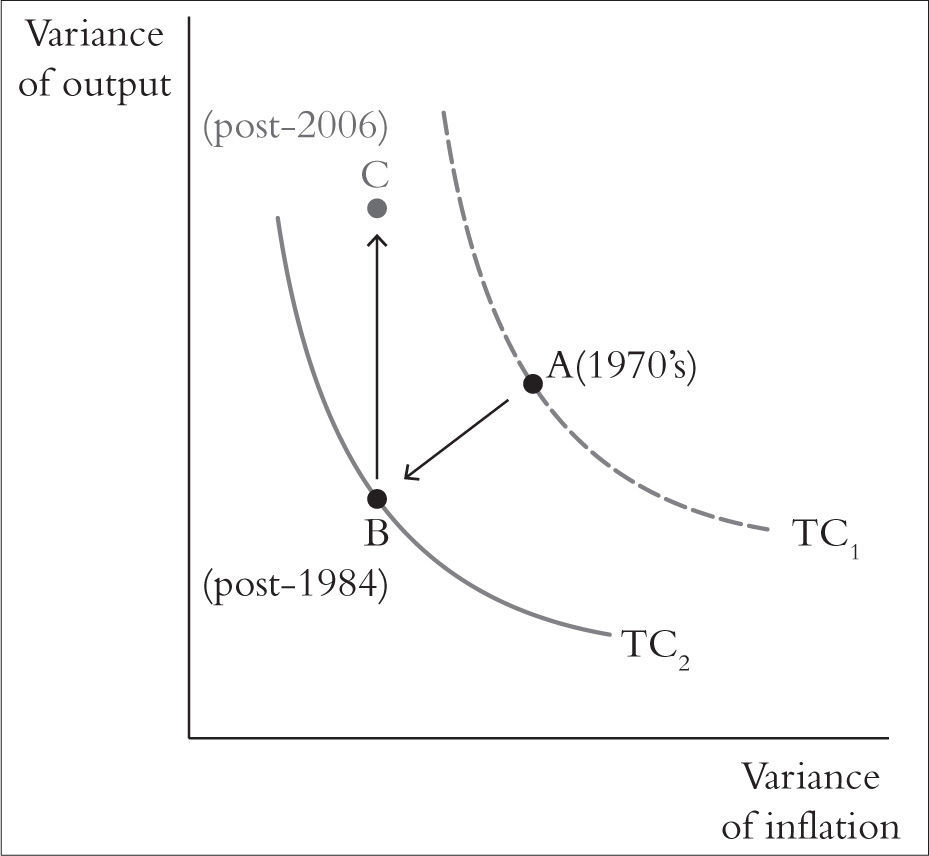

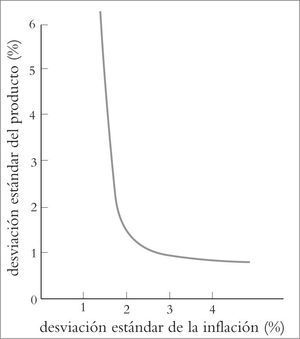

La curva formulada por Taylor terminó considerándolo a él como referencia debido a que se reconocía la originalidad de su trabajo y es parte indiscutida en el día a día de muchos bancos centrales de todo el mundo. Ben Bernanke, cuando estaba en la Fed, también la llamó así en un ajuste que sugirió realizarle luego de un cuarto de sigo (Bernanke, 2004): debido al éxito internacional en el combate a las fluctuaciones que se había alcanzado, era el momento de desplazarla hacia el origen (como en la Gráfica 5) y de generalizarla como “curva de Taylor”. El periplo de un cuarto de siglo de combate exitoso a las fluctuaciones (entre el inicio de los ochenta y mediados o fines de 2006) quedaba favorablemente marcado.

La política monetaria y la variabilidad del producto y la inflación

¿Cuál era la razón del éxito? En su mayoría el gremio se ha inclinado sin duda a descartar otras hipótesis ajenas a la buena política monetaria, como la hipótesis del cambio estructural o la hipótesis de la buena suerte. Esa buena política monetaria, considerando su fundamento de expectativas racionales, tendría que ceñirse a reglas, pero debía acompañarse del contexto más apropiado: operar con paridades flexibles y establecer algo más que un blanco numérico. Este punto pasó a llamarse “enfoque de blancos de inflación” porque amén de consignar un blanco inflacionario numérico continuo el banco central estaría obligado a rendir cuentas de manera regular y a transparentar sus decisiones de manera continua.

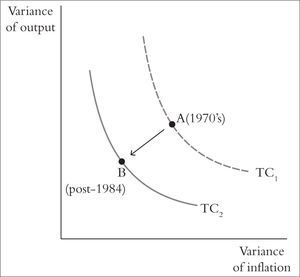

El trípode de Taylor, relativo a la buena política monetaria de largo plazo, se componía entonces de una regla de política, una paridad flexible y un enfoque de blancos de inflación, pero uno de los componentes del trípode (la regla de Taylor) falló, debido a que la Fed se separó de sus prescripciones apenas despuntaba el nuevo siglo: en lugar de mantener su blanco de la tasa de fondos federales en línea con la regla, la Fed relajó su política monetaria, lo que llevó a Taylor a volver a colocar a la economía actual en el lugar del biplano le correspondería (véase Gráfica 6), con el propósito de mostrar sus aplicaciones contemporáneas, es decir, luego de la Gran Recesión de 2008-2009 (Taylor, 2014). Esto sugeriría que el mal desempeño de la economía durante dicha recesión no podría explicarse por ortodoxia alguna sino por haberse desviado la política monetaria de sus cánones.

ConclusionesEl vínculo entre la inflación, el producto y el dinero es asunto de larga data en el pensamiento económico. Abordarlo con la distinción entre variables nominales y variables reales esclarece el lugar de las autoridades monetarias en el proceso económico general, porque permite caracterizar al banquero central como un combatiente contra la inflación –en la medida que existen factores múltiples que la originan– o caracterizarlo como a un generador de la inflación –en la medida que dicha variable nominal se origina en otra variable nominal. Esta distinción real-nominal, llamada también “dicotomía clásica” es útil cuando se intenta obtener un punto de orientación en un zipizape intelectual prolongado y de altos vuelos.

La gran influencia de Samuelson y Solow sobre el pensamiento económico de la posguerra sería ampliamente reconocida por el gremio durante largos años, incluso por el Comité Nobel en 1970 (Samuelson) y 1987 (Solow). De modo que las severas críticas de Milton Friedman y Edmund Phelps hacia ellos no han de verse como cosa que les escatime reconocimiento en otros campos, sino como parte del continuum intelectual dialógco que va asentando y consolidando el progreso de la disciplina. Por lo demás, Friedman y Phelps también fueron galardonados por el comité Nobel en 1976 y 2006, respectivamente. De cualquier modo, la tasa natural de desempleo y su corolario aceleracionista no parecen estar bajo ataque hace ya muchos años.

El uso de la hipótesis de expectativas racionales de John Muth permitió a Lucas y a Sargent, ambos reconocidos por el Comité Nobel como merecedores de su galardón, dirimir la pendiente de la curva de Phillips de largo plazo e iniciar la difuminación sistemática de ese enfoque en la econometría, la teoría económica y la política económica, mediante modelos formales. Entre los teoremas de irrelevancia resultantes fue la proposición de inefectividad la que provocó ámpulas mayores, ya sea por confusión o ya por claridad. John Taylor, y otro grupo que pasaría a establecer la nueva investigación de frontera, aceptó gran parte de los nuevos enfoques pero mantuvo el supuesto de precios pegajosos gracias a la incorporación de contratos traslapados.

Esto afianzó a la teoría moderna de la inflación, y fue entendida de diversas maneras según se defendiese el campo estándar o los enfoques heterodoxos, sin olvidar la época previa en que Samuelson y Solow delimitaban el campo estándar. Dornbusch y otros estabilizadores heterodoxos cambiaron algunas piezas de la teoría moderna de la inflación para reintroducir las políticas de ingresos, el tipo de cambio nominal y la inflación salarial, sin confiar mucho en los poderes del sistema de precios para regresar la economía al equilibrio. En un sentido teórico ese razonamiento alejaba al modelo dinámico del equilibrio competitivo. Pero Friedman ya había regresado a la política monetaria a su senda optimizadora.

John Taylor logró construír y consolidar muchos conceptos nuevos, conceptos que recogían enfoques clásicos, monetaristas y nuevoclásicos, y avanzó hacia la curva de variabilidad y el trípode que lleva también su nombre, una de cuyas puntas es la regla de Taylor. Con esas herramientas mostró las desviaciones de la Fed respecto de la buena política monetaria de largo plazo. El camino ha sido largo, no obstante las vertientes positiva y normativa han ganado en rigor y en solvencia técnica.

Profesor de la Especialización en Economía Monetaria y Financiera, Posgrado de Economía, unam y coordinador del Seminario de Credibilidad Macroeconómica, fe-unam.

Si bien Samuelson y Solow mencionan las expectativas, éstas no tienen verdadera relevancia en su explicación de los porqués del proceso inflacionario.

Los valores específicos que coincidían en el gráfico con el pleno empleo keynesiano de Samuel-son-Solow no son asunto de este paper, dados sus objetivos, y lo mismo puede decirse en relación a su enorme impacto muy pocos años después en la política macroeconómica de Estados Unidos y, a partir de ahí, en el resto del mundo. Pero es claro que sus resabios se observan hoy en día cuando alguien afirma que una cierta política contra la inflación está generando desempleo, es decir, cuando alguien sigue sosteniendo que ese antiguo trade-off está vigente.

Al supuesto de que los agentes que pueblan el modelo se rigen por la hipótesis de las expectativas racionales, que no es más que un supuesto para la modelación, algunos autores todavía hoy lo consideran una teoría económica, pero la hipótesis no dice nada acerca de si los precios y los salarios deben estipularse como flexibles o como pegajosos o cuál es la pendiente de la curva de oferta agregada. La hipótesis, desde el punto de vista de la teoría económica, es empíricamente vacía.

Y este es también un planteamiento clave, diferenciador, del modelo de equilibrio general de Lucas (1972a). A nivel didáctico la curva de oferta de Lucas postula, como estrategia modeladora, que la producción observada (Y) sólo sobrepasará a su tasa de equilibrio o natural (Yn) si existe una acción de las autoridades (o un choque) que provoque una sorpresa inflacionaria (π > πe) en los mercados, dado que Y = Yn + γ (π − πe), con 0 < γ < 1.

Este se basa en Humphrey (1985), con ligeras adecuaciones, pero existen muchos otros ejemplos didácticos.

La línea que Taylor retomaba, la de los contratos traslapados, no era nueva ni única: le antecedían autores como Costas Azariadis (a la sazón en Brown Unversity y enseguida en Pennsylvania), Stephen Ross (en Yale y Pennsylvania, en esa época), George Akerlof (quien luego recibiría el premio Nobel de Economía) o Martin Baily, de la Universidad de Chicago, y le acompañaban autores como Stanley Fischer, ampliamente conocido y ahora en la Fed, como el propio Edmund Phelps (que también sería Nobel años después), etc.

“Esta propiedad de la formación de contratos es la característica central en el modelo”,… una propiedad que regularmente no se ha enfatizado en el análisis microeconómico, pero que “es importante desde el punto de vista de la macroeconomía” (Taylor, 1979a).

Podría argumentarse que en la Teoría general de Keynes las expectativas juegan también un papel —a partir del capítulo 5, y sobre todo en el 12—, pero eso no elimina su escasa clarificación formal, lo que las hace, en principio, incontrastables con la modelación moderna, incluso la elemental, que es la que aquí se atiende.

En ese libro, además, en cuyas casi cuatrocientas páginas cupieron apuntes de filosofía social y hasta poemas alegóricos, resulta por lo menos curiosa la elección de su autor (hijo de un muy conocido economista y funcionario de la Universidad de Cambridge dedicado a la lógica formal y a la metodología) de ser excesivamente parco en expresiones matemáticas: si exceptuamos la nota 1 del capítulo 10 (dedicado a la “propensión marginal a consumir”) y las seis hojas del capítulo 20 en la edición original (dedicadas a la “función de ocupación”), Keynes decide separar del cuerpo del texto tan sólo 16 ecuaciones. Más aún: mientras John Neville Keynes, su padre, trabaja la representación diagramática de las proposiciones lógicas, la Teoría General sólo contiene un diagrama explícito (en el capítulo 14, dedicado su interpretación de la teoría clásica de la tasa de interés).

Es decir, la brecha del producto de la curva de oferta Lucas sería aproximadamente igual a la brecha de desempleo (con signo opuesto) de la recta de regresión de Okun: (1/ γ) (Y — Yn) ≈ – σ (U — Un).

Porque desde los primeros años cincuenta el matemático y economista Henri Theil contribuyó a fundamentar la econometría, la economía aplicada operó con ecuaciones estocásticas antes de que Herbert Simon (Nobel también de Economía) y el propio H. Theil establecieran al cierre de la misma década el teorema de equivalencia de certidumbre, en cuyo ámbito se origina la hipótesis de racionalidad de Muth dirigida —sólo en parte pero sin duda de un modo frontal— contra la hipótesis de “racionalidad limitada” propuesta por Simon, según la cual los modelos suponen al agente más racionalidad de la que se observa en la vida económica cotidiana.

Al contrario de quienes creen ver de manera indiferenciada ortodoxias en cada giro de la acción pública a nivel nacional, una interpretación de este cariz estuvo presente en la aplicación mexicana de políticas de ingresos durante el gobierno de Carlos Salinas, bajo el nombre inicial de Pacto de Solidaridad Económica.

Estos puntos de vista no quedaron sin réplica por parte de los nuevos clásicos, pero esa temática queda fuera de este escrito.

Dada su proyección y relevancia sobre estos ítems relativos a la inconsistencia dinámica, los autores que en este punto estaban en la reflexión de Taylor son, a no dudarlo, los actuales premio Nobel de Economía F. Kydland y Edward Prescott (1977), por un lado, y Guillermo Calvo (1978), por el otro.